未来替代硅基芯片的可能技术什么?

短期内(5-10年),类脑芯片、光子芯片、碳基芯片将在特定场景(如AI、通信、物联网)逐步替代部分硅基芯片;:用二维材料(如石墨烯、二硫化钼MoS₂)或碳纳米管(CNT)替代硅基晶体管,利用其原子级厚度、高载流子迁移率等特性,突破硅基材料的物理限制。,可能在10-20年内逐步替代部分硅基芯片(如高性能计算、物联网设备),但需解决材料工程与生态适配问题。领域补充硅基芯片(如替代DRAM、NAND闪存

未来替代或补充现有硅基芯片的技术,本质上是在信息处理效率、能耗、集成度或功能边界上突破硅基半导体的物理限制。这些技术并非完全“取代”芯片,而是在特定场景下解决硅基芯片的瓶颈(如算力天花板、功耗过高、功能单一)。以下从底层物理原理突破、架构革新、材料创新三个维度,结合当前科研进展与工程挑战,推导可能的替代方向。

一、硅基芯片的核心瓶颈:为何需要替代?

当前硅基芯片的极限源于量子效应主导的物理约束与冯·诺依曼架构的固有缺陷:

- 物理极限:晶体管尺寸缩小至3nm(约10个原子)后,量子隧穿(电子穿透绝缘层导致漏电流)、热密度(单位面积功率超100W/cm²)、信号干扰(导线间距过小导致电磁串扰)等问题无法通过工艺改进解决;

- 架构瓶颈:冯·诺依曼架构的“内存墙”(数据传输速率远低于计算速率)限制了算力提升,且无法高效处理AI/神经网络等并行计算任务;

- 成本飙升:3nm芯片流片成本超3亿美元,先进制程依赖EUV光刻机(单价超1.5亿美元),摩尔定律的经济性逐渐失效。

因此,替代技术需在算力密度、能耗、成本、功能扩展性上实现突破。

二、可能的替代/补充技术方向

方向1:量子计算——突破经典计算的算力天花板

核心原理:利用量子比特(Qubit)的叠加态与纠缠态,实现并行计算,解决经典计算机无法处理的复杂问题(如大数分解、量子化学模拟)。

优势:

- 算力指数级增长:n个量子比特可同时处理2n2^n2n种状态(经典计算机仅n种);

- 特定场景碾压:如Shor算法可破解RSA加密(经典计算机需数千年,量子计算机仅需数小时),Grover算法加速数据库搜索(平方根级提升)。

当前进展与挑战:

- 进展:IBM Osprey(433量子比特)、谷歌Sycamore(53量子比特)已实现“量子优越性”;纠错技术(如表面码)逐步成熟,推动实用化。

- 挑战:

- 量子比特数量与质量:需百万级高保真量子比特(当前仅数百个,且错误率高);

- 极低温环境(接近绝对零度):需大型稀释制冷机(成本超千万美元),难以普及;

- 应用局限:仅适用于特定问题(如优化、密码学),无法替代通用计算芯片。

结论:量子计算是特定领域的“算力革命”,而非通用芯片的直接替代,未来可能与经典芯片协同(如量子-经典混合计算)。

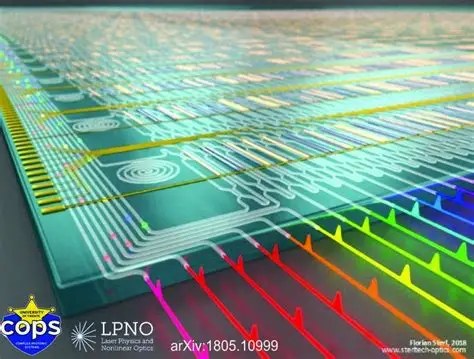

方向2:光子计算——用光信号替代电子信号

核心原理:利用光的相干性、高速传播(光速)和低互扰特性,实现高速、低功耗的信息处理与传输。

优势:

- 能耗极低:光信号传输几乎无焦耳热(电子迁移能耗高);

- 带宽极大:单根光纤可同时传输百万路信号(电子导线仅数路);

- 并行性强:光波矢、偏振、相位等多维度可编码信息,天然适合并行计算(如图像处理、AI卷积)。

当前进展与挑战:

- 进展:MIT开发出光子芯片(如“光子集成电路”),实现光逻辑门;华为、英特尔等布局硅光芯片(结合硅基与光子技术)。

- 挑战:

- 光子操控难度高:光信号易散射、吸收,需精密光学元件(如波导、调制器);

- 集成度不足:光子器件尺寸(微米级)大于电子晶体管(纳米级),难以高密度集成;

- 光电转换损耗:光信号与电信号需频繁转换(如激光器→调制器→探测器),引入额外功耗。

结论:光子计算可能在通信与并行计算场景(如数据中心光互连、AI推理)率先替代部分电子芯片,但通用计算仍需与电子芯片结合。

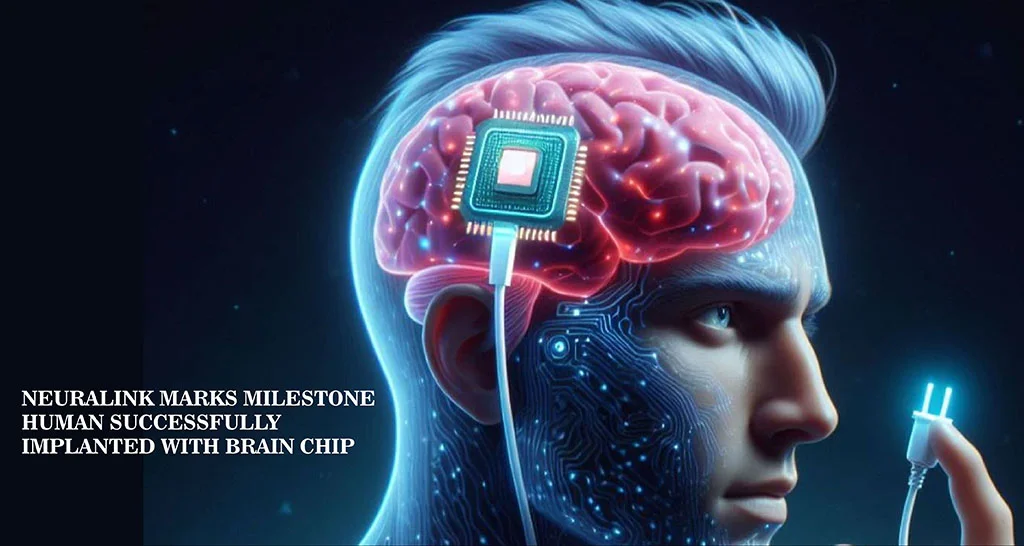

方向3:神经形态计算——模拟人脑的“类脑芯片”

核心原理:模仿生物神经元的脉冲传递与突触可塑性,采用“事件驱动”替代传统的“时钟驱动”,大幅降低功耗。

优势:

- 能效比极高:人脑仅需20W功耗处理复杂任务(当前AI芯片需数千瓦);

- 实时性强:神经元仅在事件触发时工作(如视觉芯片仅感知光线变化时计算);

- 适合AI任务:天然适配神经网络(如卷积、循环网络),减少冗余计算。

当前进展与挑战:

- 进展:IBM TrueNorth(4096个神经核心,模拟100万神经元)、英特尔Loihi(64核,模拟13万神经元)已实现类脑架构;国内寒武纪、地平线推出类脑芯片用于自动驾驶。

- 挑战:

- 算法适配:需重构AI框架(如从深度学习到脉冲神经网络SNN),生态不成熟;

- 功能单一:当前类脑芯片仅擅长特定任务(如传感器数据处理),通用计算能力弱于硅基芯片;

- 材料限制:需新型忆阻器(模拟突触)等器件,稳定性与规模化生产待突破。

结论:类脑芯片是AI时代的“专用芯片革命”,可能在边缘计算(如智能传感器、机器人)替代部分GPU/TPU,但短期内无法覆盖通用计算场景。

方向4:二维材料与碳基芯片——延续摩尔定律的“硅基接班人”

核心原理:用二维材料(如石墨烯、二硫化钼MoS₂)或碳纳米管(CNT)替代硅基晶体管,利用其原子级厚度、高载流子迁移率等特性,突破硅基材料的物理限制。

优势:

- 尺寸更小:二维材料可制备单原子层晶体管(理论极限<1nm),继续推进摩尔定律;

- 性能更强:石墨烯载流子迁移率是硅的100倍以上,碳纳米管电子迁移率接近理论极限;

- 能耗更低:原子级厚度减少漏电流,适合低功耗场景。

当前进展与挑战:

- 进展:MIT已制备出碳纳米管芯片(16位RISC-V处理器);台积电研究二维材料晶体管(如MoS₂);三星探索石墨烯晶体管。

- 挑战:

- 制造工艺不成熟:二维材料难以大规模均匀沉积(如CVD生长缺陷率高);

- 接触电阻问题:金属与二维材料的接触界面电阻大(影响性能);

- 集成度不足:缺乏配套的EDA工具与封装技术(当前硅基生态成熟,二维材料需重建产业链)。

结论:碳基/二维材料芯片是硅基芯片的“延续方案”,可能在10-20年内逐步替代部分硅基芯片(如高性能计算、物联网设备),但需解决材料工程与生态适配问题。

方向5:自旋电子学——利用电子自旋存储与计算

核心原理:电子自旋(量子属性)替代电荷作为信息载体,利用自旋极化传输信号,自旋弛豫实现存储,突破“电荷型器件”的能耗限制。

优势:

- 非易失性:自旋状态无需持续供电(类似闪存,但速度更快);

- 低功耗:自旋传输能耗远低于电荷输运(无焦耳热);

- 多功能集成:自旋可用于存储(自旋转移矩磁随机存储器STT-MRAM)、逻辑计算(自旋晶体管)。

当前进展与挑战:

- 进展:Everspin已推出商用STT-MRAM(用于服务器缓存);IBM研究自旋逻辑器件(如自旋轨道力矩器件)。

- 挑战:

- 自旋操控难度高:需强磁场或自旋极化电流(增加系统复杂度);

- 集成度低:自旋器件与CMOS工艺兼容性差(需额外磁场屏蔽或材料改性);

- 速度限制:自旋弛豫时间(皮秒级)短于晶体管开关时间(飞秒级),高频应用受限。

结论:自旋电子学可能在存储与低功耗逻辑领域补充硅基芯片(如替代DRAM、NAND闪存),但难以全面替代通用计算芯片。

三、未来芯片的“混合形态”:多技术协同

单一技术难以解决所有问题,未来芯片更可能是多种技术的融合:

- 量子-经典混合芯片:用量子芯片处理特定问题(如密码破解),经典芯片处理通用计算;

- 光子-电子混合芯片:用光子芯片负责高速数据传输(如芯片间互连),电子芯片负责逻辑计算;

- 类脑-硅基混合芯片:用类脑芯片处理传感器数据(如实时图像识别),硅基芯片负责复杂决策;

- 碳基-硅基混合芯片:用碳基晶体管替代硅基晶体管(如高性能计算核心),硅基芯片负责外围电路。

总结:替代芯片的“技术路线图”

| 技术方向 | 核心优势 | 适用场景 | 商业化时间 |

|---|---|---|---|

| 量子计算 | 算力指数级增长(特定问题) | 密码学、量子化学模拟 | 10-20年(专用机先行) |

| 光子计算 | 高速低功耗(并行计算) | 数据中心光互连、AI推理 | 5-10年(部分替代) |

| 类脑芯片 | 极低功耗(事件驱动) | 边缘AI、智能传感器 | 3-5年(专用场景落地) |

| 碳基/二维材料芯片 | 延续摩尔定律(更小尺寸) | 高性能计算、物联网设备 | 10-15年(逐步替代) |

| 自旋电子学 | 非易失性+低功耗(存储/逻辑) | 存储器、低功耗微控制器 | 5-10年(补充现有存储) |

最终结论:未来不会有单一技术“完全取代”芯片,而是通过多技术协同解决硅基芯片的瓶颈。短期内(5-10年),类脑芯片、光子芯片、碳基芯片将在特定场景(如AI、通信、物联网)逐步替代部分硅基芯片;长期(10年以上),量子计算可能在特定领域引发“算力革命”,但通用计算仍需与经典芯片结合。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)