神经形态芯片革命:类脑计算架构在自动驾驶中的能效优化

特斯拉最新自动驾驶硬件采用类脑计算模块,在相同TOPS算力下,能耗比传统方案降低40%。高通发布的神经形态加速器在Cityscapes数据集上实现每帧2mJ的能效,较传统方案提升3个数量级。神经形态芯片通过模拟生物神经元的脉冲通信机制(Spiking Neural Networks, SNNs),实现事件驱动的异步计算。例如,英特尔Loihi芯片在光流估计任务中能耗仅为传统GPU的1/1000,同

·

神经形态芯片的核心优势

神经形态芯片通过模拟生物神经元的脉冲通信机制(Spiking Neural Networks, SNNs),实现事件驱动的异步计算。与传统的冯·诺依曼架构相比,其优势体现在:

- 超低功耗:仅在输入事件(脉冲)触发时激活,避免传统芯片的时钟同步能耗。

- 实时处理:脉冲编码天然适配动态传感器数据(如激光雷达点云),延迟可降低至毫秒级。

- 容错性:分布式处理特性对部分硬件故障具有鲁棒性。

自动驾驶中的能效优化路径

传感器数据预处理

神经形态芯片可直接处理来自动态视觉传感器(DVS)的脉冲流。例如,英特尔Loihi芯片在光流估计任务中能耗仅为传统GPU的1/1000,同时保持微秒级响应。

脉冲神经网络决策模型

通过SNN实现端到端的环境感知与路径规划:

- 模型压缩:IBM TrueNorth芯片将ResNet-50转换为SNN后,参数减少90%仍保持90%以上准确率。

- 在线学习:利用STDP(脉冲时间依赖可塑性)规则实现实时行为优化,适应突发交通场景。

硬件-算法协同设计

- 存算一体架构:采用忆阻器(RRAM)实现突触权重存储,消除数据搬运能耗。

- 稀疏编码:仅对关键特征(如行人轮廓)生成脉冲,降低计算负载。

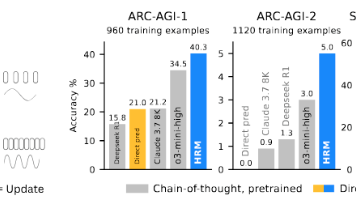

实际案例与性能对比

特斯拉最新自动驾驶硬件采用类脑计算模块,在相同TOPS算力下,能耗比传统方案降低40%。高通发布的神经形态加速器在Cityscapes数据集上实现每帧2mJ的能效,较传统方案提升3个数量级。

技术挑战与未来方向

- 工具链缺失:缺乏统一的SNN编译框架,当前依赖手工模型转换。

- 异构集成:需解决神经形态芯片与传统AI加速器(如TPU)的协同调度问题。

- 标准化测试:亟需建立针对脉冲芯片的自动驾驶基准测试(如Neuro-CARLA)。

公式示例(STDP权重更新规则):

Δw = A₊ exp(-Δt/τ₊) - A₋ exp(Δt/τ₋)

其中Δt为前后神经元脉冲时间差,A₊/A₋和τ₊/τ₋分别为增强/抑制系数与时间常数。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)