实时脑肿瘤诊断:一种新型轻量级深度学习模型的应用

脑肿瘤仍是全球范围内的主要致死原因之一,这凸显了对有效且精准诊断工具的迫切需求。本文提出了 MK-YOLOv8—— 一种创新性轻量级深度学习框架,该框架专为从磁共振成像(MRI)图像中实时检测和分类脑肿瘤而开发。该模型以 YOLOv8 架构为基础,集成了 Ghost 卷积、C3Ghost 模块和 SPPELAN 模块,旨在提升特征提取能力并大幅降低计算复杂度。模型中新增了一个超小目标检测层,可支持

摘要:

脑肿瘤仍是全球范围内的主要致死原因之一,这凸显了对有效且精准诊断工具的迫切需求。本文提出了 MK-YOLOv8—— 一种创新性轻量级深度学习框架,该框架专为从磁共振成像(MRI)图像中实时检测和分类脑肿瘤而开发。该模型以 YOLOv8 架构为基础,集成了 Ghost 卷积、C3Ghost 模块和 SPPELAN 模块,旨在提升特征提取能力并大幅降低计算复杂度。模型中新增了一个超小目标检测层,可支持对小型和超小型肿瘤的精准检测,这对肿瘤的早期诊断至关重要。在包含 3064 张 MRI 图像的 Figshare 脑肿瘤(FBT)数据集上训练后,MK-YOLOv8 在交并比(IoU)为 0.50 时的平均精度均值(mAP)达到 99.1%,在 IoU 为 0.50–0.95 时的 mAP 达到 88.4%,性能优于 YOLOv8(YOLOv8 在上述两个 IoU 阈值下的 mAP 分别为 98% 和 78.8%)。其中,胶质瘤的召回率提升了 26%,这凸显了该模型对这类诊断难度较大的肿瘤类型的敏感性有所增强。MK-YOLOv8 的计算量仅为 96.9 千兆浮点运算(GFLOPs),仅为 YOLOv8x 计算量的 37.5%;其参数数量为 1260 万,仅为 YOLOv8 参数数量的 18.5%,实现了高效率且低资源需求的性能表现。此外,为验证模型的鲁棒性和泛化能力,研究人员还在 Br35H 数据集(含 801 张图像)上对其进行了训练,该模型在 IoU 为 0.50 时的 mAP 达到 98.6%。该模型的运行速度为 62 帧 / 秒(FPS),适用于实时临床诊疗流程。这些改进使 MK-YOLOv8 成为一种创新性框架,不仅解决了微小肿瘤识别中的难点问题,还为临床场景下的脑肿瘤诊断提供了一种具有泛化性、适应性且精准的检测方法。

1. 引言(Introduction)

脑肿瘤仍是全球范围内的主要致死原因之一,这凸显了对有效且精准诊断工具的迫切需求。本文提出了MK-YOLOv8——一种创新性轻量级深度学习框架,该框架专为从磁共振成像(MRI)图像中实时检测和分类脑肿瘤而开发。该模型以YOLOv8架构为基础,集成了Ghost卷积、C3Ghost模块和SPPELAN轻量级模块,旨在提升特征提取能力并大幅降低计算复杂度。模型中新增了一个超小目标检测头,可支持对小型和超小型肿瘤的精准检测,这对肿瘤的早期诊断至关重要。

在包含3064张MRI图像的Figshare脑肿瘤(FBT)数据集上,研究人员采用最佳权重自适应技术(BWAT)对MK-YOLOv8进行训练,结果显示该模型在交并比(IoU)为0.50时的平均精度均值(mAP)达到99.1%,在IoU为0.50–0.95时的mAP达到88.4%,性能优于YOLOv8(YOLOv8在上述两个IoU阈值下的mAP分别为98%和78.8%)。其中,胶质瘤的召回率提升了26%,这凸显了该模型对这类诊断难度较大的肿瘤类型的敏感性有所增强。

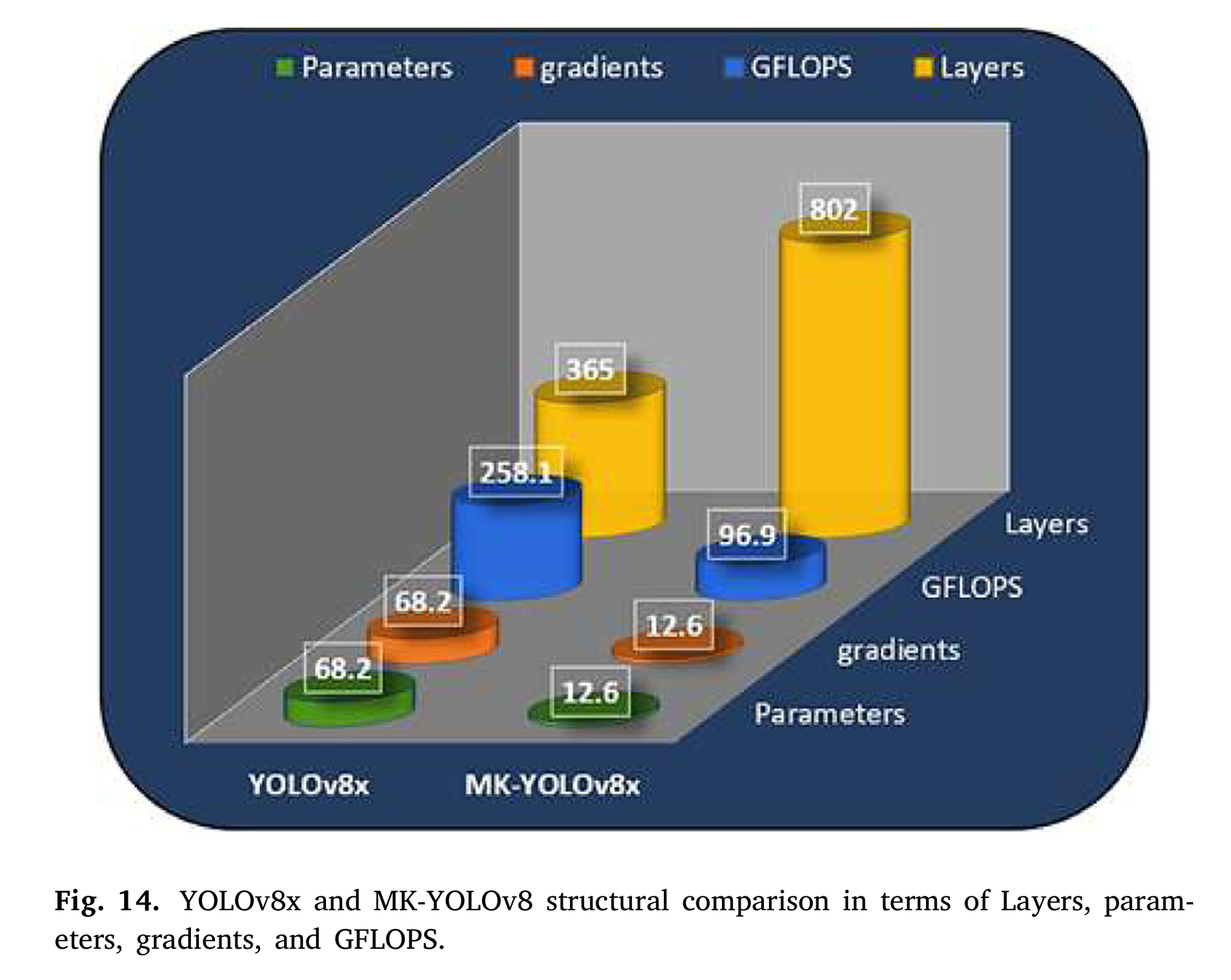

MK-YOLOv8的计算量仅为96.9千兆浮点运算(GFLOPs),仅为YOLOv8x计算量的37.5%;其参数数量为1260万,仅为YOLOv8参数数量的18.5%,实现了高效率且低资源需求的性能表现。此外,为确保模型的鲁棒性和泛化能力,研究人员还在Br35H数据集(含801张图像)上对其进行了训练,该模型在IoU为0.50时的mAP达到98.6%。该模型的运行速度为62帧/秒(FPS),适用于实时临床诊疗流程。这些改进使MK-YOLOv8成为一种创新性框架,不仅解决了微小肿瘤识别中的难点问题,还为临床场景下的脑肿瘤诊断提供了一种具有泛化性、适应性且精准的检测方法。

脑膜瘤大多为良性肿瘤,通常发生在包裹大脑的蛛网膜(脑膜的一种)中[1]。尽管脑膜瘤为良性,但仍会直接威胁人类生命。脑膜瘤往往集中在大脑的上部和外侧轮廓区域,占所有原发性脑肿瘤的36.1%。这类肿瘤表现为脑膜上的隆起状病变,而脑膜是包裹并保护脊髓和大脑的三层膜状结构,脑膜瘤便是起源于这层膜的三种肿瘤类型之一。根据脑膜瘤的解剖位置、形态和细胞结构,可对其进行诊断。

这类肿瘤可能会产生严重的不良影响,例如抽搐和视力丧失,且病情进展较为缓慢。另一方面,胶质瘤并非起源于神经元,而是来源于大脑中的神经胶质细胞。胶质瘤在脑肿瘤中占比颇高,其恶性程度和危害症状差异极大。此外,在颅底细胞环绕的脑垂体周围,也可能形成异常肿块状的肿瘤。由于脑垂体对调节激素的生成与分泌至关重要,因此这类垂体周围的肿瘤可能会影响多个生理系统。深入了解脑肿瘤疾病的不同阶段,对于脑肿瘤的控制和有效治疗至关重要。

近年来,放射科医生采用多种成像技术组合来检查脑肿瘤,以辅助精准诊断和治疗方案选择,这些技术包括计算机断层扫描(CT)、X射线、脑磁图(MEG)、超声、磁共振成像(MRI)和脑电图(EEG)。由于原发性脑肿瘤在位置、大小和其他特征上存在显著差异,其早期诊断具有一定挑战性。由于组织的吸收特性使无创成像技术能够准确呈现肿瘤形态,因此准确定义组织的吸收速率对于有效的肿瘤成像至关重要[2]。

在各类成像方式中,磁共振成像(MRI)因其能够获取大脑健康状态和病变状态下的详细信息,成为脑肿瘤检测的“黄金标准”。当发现异常情况时,MRI还有助于确定肿瘤的具体类型[3]。然而,解读MRI扫描结果需要极高的专业技能和细致程度,这超出了普通人的能力范围。遗憾的是,部分医院和医疗机构因缺乏具备此类专业能力的人员,导致诊断流程延长[4]。

随着计算机视觉和机器学习领域的快速发展,卷积神经网络(CNN)成为了一种强大的解决方案。这些最先进的模型已成功解决了复杂的计算机辅助诊断(CAD)问题,包括肿瘤检测、分类甚至分割[5-9]。然而,目前许多采用CNN进行脑肿瘤识别与检测的CAD系统,在跨平台使用时效率较低,且需要大量的计算资源。此外,轻量级CNN分类算法在准确定位肿瘤位置方面存在固有的局限性[10]。

尽管分割模型的计算成本更高,但通过使用掩码标记病变区域,分割模型能够精准定位肿瘤位置。然而,这一过程在使用常规技术时会面临挑战,导致运行效率低下且结果欠佳。近年来,如文献[11]所述,改进的机器学习方法在医学成像领域表现卓越,尤其在脑肿瘤识别这类高难度任务中成效显著。研究人员已开发出多种目标检测方法,以提高图像中不同目标的识别能力[12,13]。 其中值得关注的模型包括R-CNN、Fast R-CNN[14,15]以及单发多框检测器(SSD)[14,16]。在当前研究中,自监督深度学习模型也被用于利用聚合语义和位置信息来提升性能[17]。然而,You-Only-Look-Once(YOLO)方法[18]凭借其单一统一的神经网络结构和出色的目标检测性能[19],吸引了广泛关注。该方法将目标检测视为回归问题,直接从像素级数据中计算边界框坐标和类别概率,彻底改变了目标检测领域。它能够同步预测多个类别概率和边界框,从而在速度和精度上实现了双重提升。

及时诊断和准确分类对于有效治疗至关重要,但当前的诊断方法仍面临重大局限。尽管MRI等成像技术取得了突破,但脑肿瘤的有效且及时识别仍是一大难题。现有解决方案主要依赖人工标注或计算复杂度高的分割模型,在实时应用中效率较低。轻量级CNN方法虽前景广阔,但在识别微小肿瘤(早期治疗必需的检测目标)方面通常表现欠佳。这些局限性凸显了开发新型有效方法的迫切需求——需在诊断精度与临床实际应用之间搭建桥梁。

受这些问题的启发,本研究尝试构建所提出的模型,该模型采用轻量级深度学习方法来克服上述缺陷,在提升检测精度的同时降低计算复杂度,使其适用于脑肿瘤的实时识别与分类。本研究采用了两种YOLO深度学习模型变体:传统YOLOv8和轻量级YOLOv8,这两种模型为从MRI数据中检测和分类脑肿瘤提供了更高效的方法。本文的主要贡献如下:

1. **数据集改进与定制**:本研究通过将Figshare脑肿瘤(FBT)数据集[20]转换为适用于YOLO模型的格式,为后续研究奠定了新基础。这种格式转换过程包含标注步骤——生成与YOLO兼容的标签和边界框。该改进不仅提高了数据集在目标检测任务中的可用性,还通过支持实时应用场景下的高效评估与训练,解决了现有公开脑肿瘤数据集存在的问题。

2. **实时新型轻量级检测框架的开发**:本研究提出了MK-YOLOv8模型——一种用于脑肿瘤检测与分类的新型轻量级深度学习框架。该模型在架构上进行了多项先进改进,包括集成Ghost卷积、C3Ghost模块和SPPFLAN模块,以及新增超小目标检测头。这些调整显著提升了特征提取效率,降低了计算复杂度,并实现了对小型和超小型肿瘤的精准检测。该模型的轻量级架构确保了其在资源受限环境中的兼容性,使其适用于集成到临床工作流程中(如术中成像和自动化诊断系统),从而缩短诊断延迟,提升实际临床环境中的决策效率。

3. **首创基于YOLOv8的脑肿瘤检测与分类框架**:本文首次将YOLOv8和所提出的MK-YOLOv8模型应用于基于FBT数据集的脑肿瘤检测与分类任务,这是已知研究中首次将这两种架构用于该数据集。此外,为凸显模型的鲁棒性和泛化能力,研究人员还在Br35H数据集上测试了MK-YOLOv8模型,证明其在不同MRI数据集上均具有可靠性能。

4. **评估方法**:本研究提出了一种系统、全面的评估方法,用于评估脑肿瘤检测与分类领域的轻量级深度学习模型。通过采用多种评估指标(包括召回率、精度、F1分数以及不同阈值下的平均精度均值(mAP),如mAP(0.50)和mAP(0.50–0.95)),为分析所提MK-YOLOv8模型的性能提供了稳健的框架。

5. **与分类模型的对比分析**:本研究将所提MK-YOLOv8模型与标准YOLOv8及其他已知方法(如Faster R-CNN和Mask R-CNN)进行了严谨的性能对比。结果表明,MK-YOLOv8在整体性能上有显著提升,尤其在检测胶质瘤等诊断难度较大的肿瘤类型时表现突出。

本文其余部分结构安排如下:第2节将全面综述相关文献、阐述本研究的覆盖范围及研究需求;第3节将介绍基于脑肿瘤检测与分类的深度学习研究方法,包括数据收集、预处理、机器学习方法及性能分析技术;第4节将呈现数值结果,并分析所研究机器学习算法的性能;第5节将探讨未来工作方向,并将所提机器学习结构的性能与现有文献中的最先进成果进行对比;第6节作为最后一节,将总结主要研究结论与启示。

2. 文献综述

尽管早期脑肿瘤识别具有挑战性,但深度学习算法已取得长足进展,如今能够从数字图像中可靠地识别脑癌。脑肿瘤识别的标准技术包括磁共振成像(MRI)、计算机断层扫描(CT)和脑电图(EEG)。当深度学习模型与MRI和CT图像结合使用时,脑肿瘤检测的准确率得到了提升。由于循环神经网络(RNN)[21]、卷积神经网络(CNN)[2,21,22]、自编码器(AE)[23–26]、迁移学习以及混合算法[27,28]具有早期检测能力和高精确度,研究人员已对这些基于机器学习的算法展开了深入研究。例如,研究人员目前倾向于使用CNN来识别和分类脑癌。

BrainMRNet[29]模型结合磁共振(MR)图像和CNN,采用端到端算法进行癌症识别。该数据集包含253幅图像,其中155幅为肿瘤图像,98幅为正常图像。在使用标准参数评估时,该模型的灵敏度达到96%、准确率达到96%、精确率达到92%。同样,文献[22]中的一项研究提出将3D卷积神经网络(3D CNN)用作分类模型,并通过前馈神经网络(feedforward NN)验证提取的特征。该研究采用预训练的VGG19网络完成特征提取过程。他们的模型在BraTS(2018、2016和2015)数据集上进行训练和评估,准确率分别为92%、96%和98%。尽管该模型的性能会因数据集不同而波动,但他们的研究偶尔会得出准确率更高的结果。文献[30]提出了一种基于图像块的深度神经网络(patch-based DNN),用于基于MR图像的脑肿瘤分类。研究使用了8个数据集对所提模型进行全面评估,其中包括BraTS 2012–2015、医学图像计算与计算机辅助干预会议(MICCAI)数据集以及缺血性脑卒中病灶分割(ISLES)2015–2017数据集。该方法在多个数据集和模态上均表现出稳定性能,在BraTS 2013数据集上的Dice相似系数高达99.8%,达到最佳水平。文献[31]的研究者采用深度神经网络(DNN)和分割方法,提出了一个脑肿瘤自动检测系统。该模型使用MR图像在BraTS 2013数据集上进行训练。该模型研究了一种结合局部和全局变量的新型诊断方法。该模型表现出良好性能,Dice评分达85%、特异度达93%、灵敏度达80%。

为识别胶质瘤这类脑肿瘤,文献[32]的研究提出了一种机器学习模型,该模型采用由双路径和三路径网络构成的混合卷积神经网络。在BraTS 2013数据集上测试时,该模型的Dice评分、特异度和灵敏度分别为0.86、0.91和0.86。该数据集包含20名患者的扫描图像,共80幅,涵盖4种不同模态。近期有研究[33]采用预训练的Densenet201机器学习模型,提出了一个用于多类别脑肿瘤分类的决策支持系统(DSS)。该决策支持系统采用两种不同的元启发式算法进行特征选择。研究人员在BraTS(2018–2019)数据集上对该模型进行训练和评估,其中支持向量机(SVM)分类器的准确率高达95%。已有多项研究[34,35,36]基于本研究中所使用的Figshare脑肿瘤(FBT)数据集,开展脑肿瘤分类研究。例如,文献[34]的研究在典型的CNN模型中融入了因式分解双线性编码和定制化双抑制编码。该模型在多个数据集上经过大量测试后,准确率达到95%。文献[35]的研究还提出了一种残差网络,用于基于迁移学习的脑肿瘤分类。研究采用AlexNet、ConvNet和VGG 16等标准算法验证所提算法的正确性。该模型在FBT数据集上的准确率达到95%。

开发轻量级模型(包括基于YOLO架构的模型)已被证明有助于在资源受限环境中完成实时检测和分类任务[37]。YOLO模型兼具速度和效能优势,因此有多名研究人员将其用于医学图像中的目标识别[38–41]。YOLOv5目标识别模型与移动式微波头部成像(MWHI)系统结合后,可对人脑异常区域进行自动检测和分类。YOLOv5l模型在400幅微波成像(RMW)图像(包含不同位置的肿瘤和非肿瘤样本)上取得了优异性能:F1分数为95.53%、准确率为96.12%、精确率为95.17%、灵敏度为94.98%、平均精度均值(mAP)为96.12%、特异度为95.28%。同样,文献[42]的研究采用迁移学习技术,在BraTS 2020数据集上应用YOLOv5进行脑肿瘤检测。YOLOv5l模型在400幅微波成像(RMW)图像样本(包含不同位置的非肿瘤和肿瘤案例)上表现出色,其F1分数为95.53%、准确率为95.53%、精确率为95.17%、灵敏度为94.98%、平均精度均值(mAP)为96.12%。此外,文献[42]的研究同样采用迁移学习方法,在BraTS 2020数据集上应用YOLOv5进行脑肿瘤识别。在各版本YOLO模型中,YOLOv5的性能最优。所提模型的精确率在82%至92%之间波动。他们的研究结果还表明,训练准确率和训练时间之间存在权衡关系。目前已对脑肿瘤分类和诊断相关的重要研究、模型、工具及技术进行了总结。

文献综述表明,不同的目标检测模型可与分类算法结合,用于脑肿瘤的识别和分类。影响这些模型准确率的因素包括所使用的数据集、提取的特征以及所选模型的复杂度。在各类目标检测模型中,YOLO在包括医学成像在内的多个领域均取得了良好效果。然而,超轻量级CNN分类算法在正确识别小目标方面仍存在困难。YOLO等分割模型可解决这一局限性,但代价高昂。本研究旨在通过采用最新的目标检测和分类模型,在降低计算成本的同时,实现全面的实时准确率和最优性能,并保证高速运行。

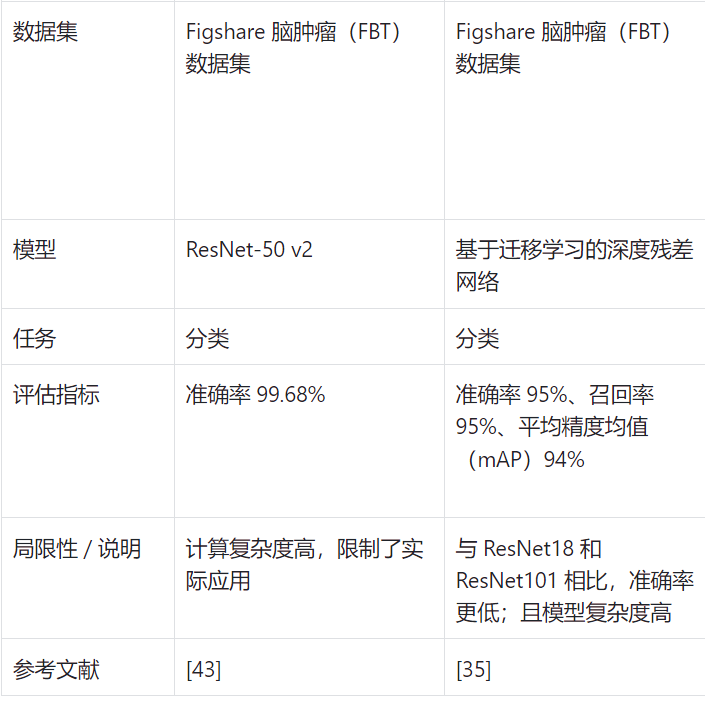

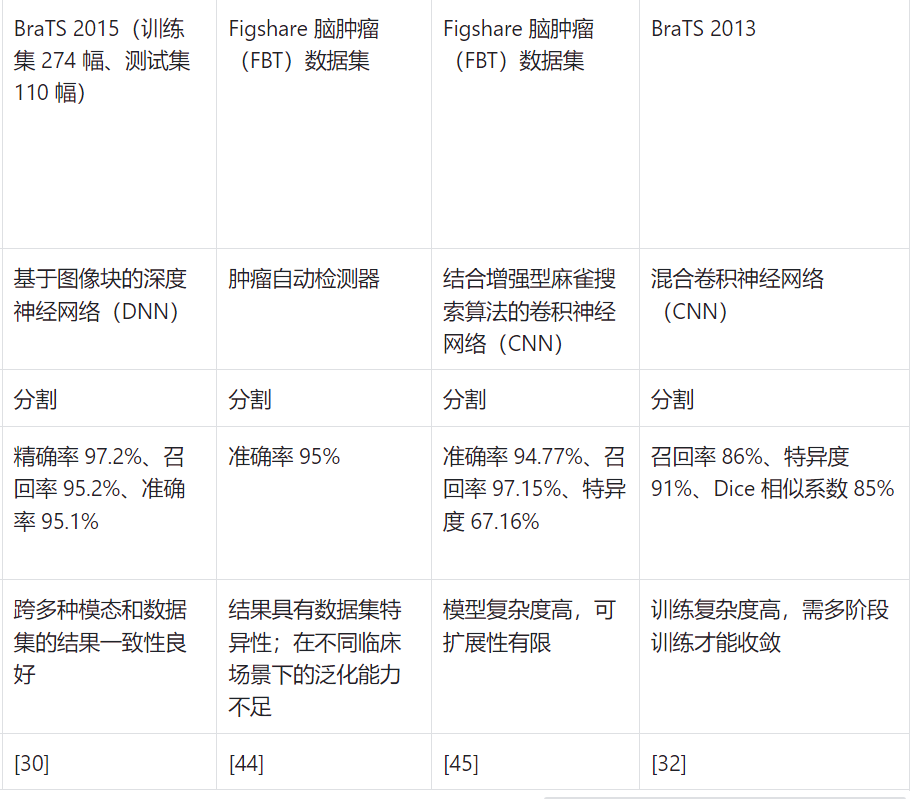

文献[43]提出了一种融合迁移学习方法的新型深度学习策略,该策略采用ResNet50-v2模型,准确率达到了惊人的99.68%。此外,文献[44]以掩码图像为标签,提出了一种肿瘤自动检测与分割方法,其分割准确率达到95%。与早期方法相比,文献[45]中描述的计算机辅助系统(包含基于CNN的分割、分类和预处理模块)效率更高。需要注意的是,在提供的图像中,部分分割结果的呈现需更加精确。文献[46]的研究采用Faster R-CNN算法进行肿瘤检测,其平均精确率为77.60%。文献[47]提出了一种CNN架构,该架构对肿瘤的分类准确率可达96.56%。文献[48]通过将灰度共生矩阵数据与预训练CNN结合,实现了96.5%的准确率。由于早期研究中缺乏足够可靠的实验数据,难以对模型的整体性能进行详细分析。此外,部分研究缺失召回率或特定检测阈值等关键指标,这使得难以全面评估和比较相关研究及模型的效能(见表1)。

表一

3. 所提方法

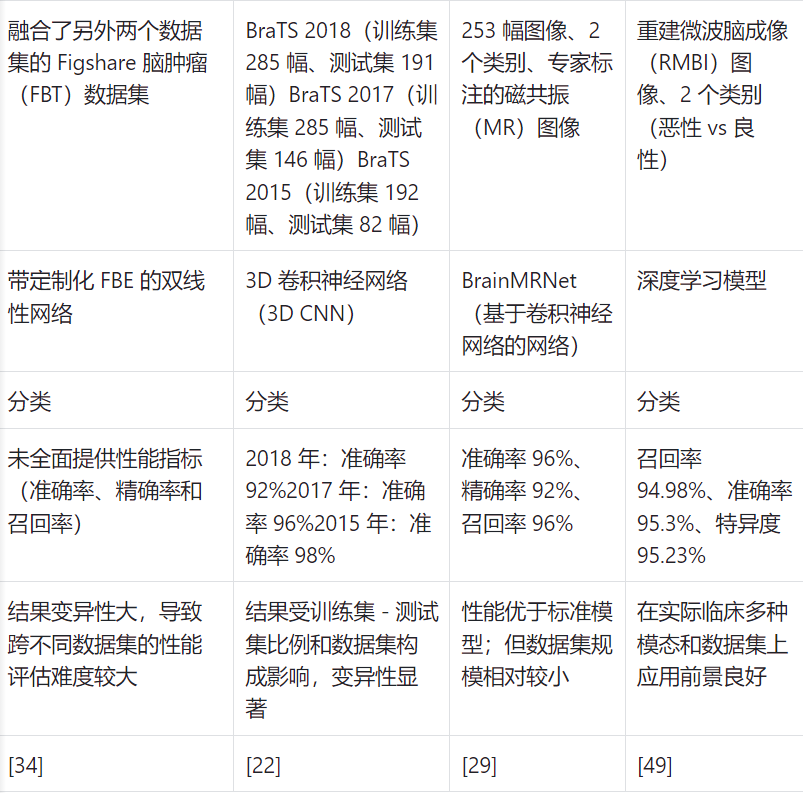

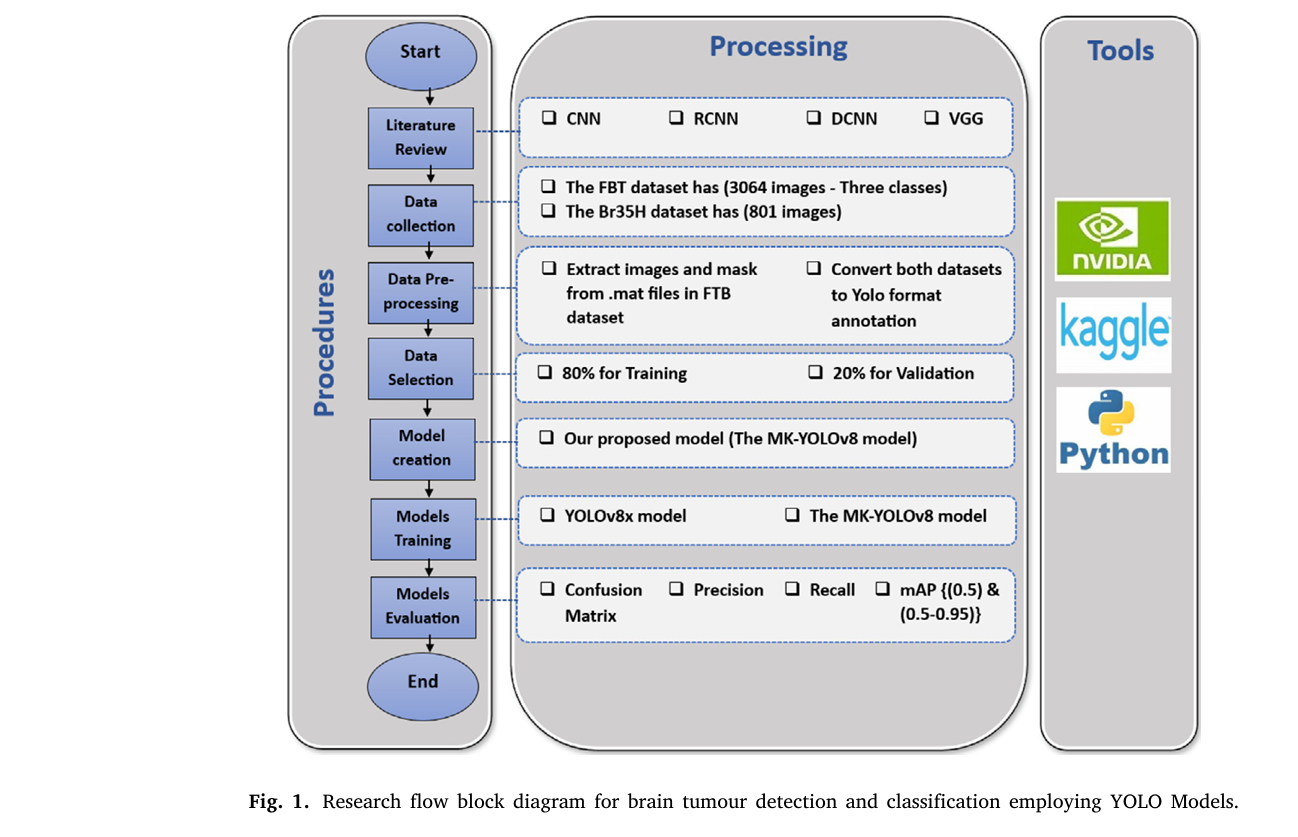

本研究的关键流程如图 1 所示,流程始于对相关文献(包括最新研究)的全面综述,随后进行数据集构建。接下来,对数据进行预处理与筛选。构建所提模型后,采用标准参数对其进行训练和评估,以完成上述流程。

3.1. 数据收集(Data collection)

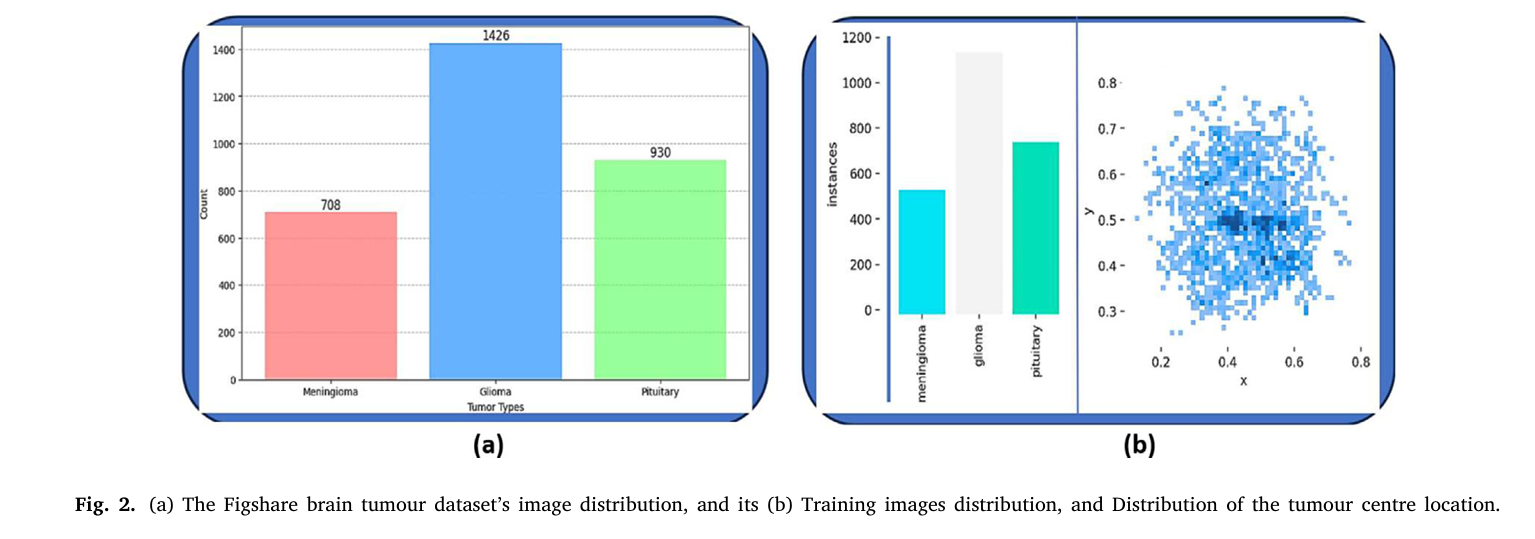

本研究采用两个数据集对所提出的MK-YOLOv8脑肿瘤检测与分类模型进行训练和评估。 本研究使用的主要数据集是来自广州南方医科大学(Southern Medical University, SMU)的FBT数据集(Figshare脑肿瘤数据集),该数据集来源于文献[20,50],包含233个病例的3064张MRI图像,分为三种肿瘤类型:脑膜瘤(709张图像,占比23.11%)、胶质瘤(930张图像,占比30.35%)和垂体瘤(1425张图像,占比46.54%),每张图像的尺寸均为512像素。 预处理阶段包括将.mat文件转换为.png格式、对齐用于边界框标注的肿瘤掩码,以及将边界框坐标归一化为YOLO检测格式。 为确保模型的可靠性,本研究还使用了包含801张带标注MRI扫描图像的Br35H数据集。 该数据集随后被划分为包含641张图像的训练集和160张扫描图像的验证集。 这些数据集为评估所提模型的泛化能力以及对不同临床情况的适应性提供了良好的基础。

3.2. 数据预处理与数据选择(Data pre-processing and data selection)

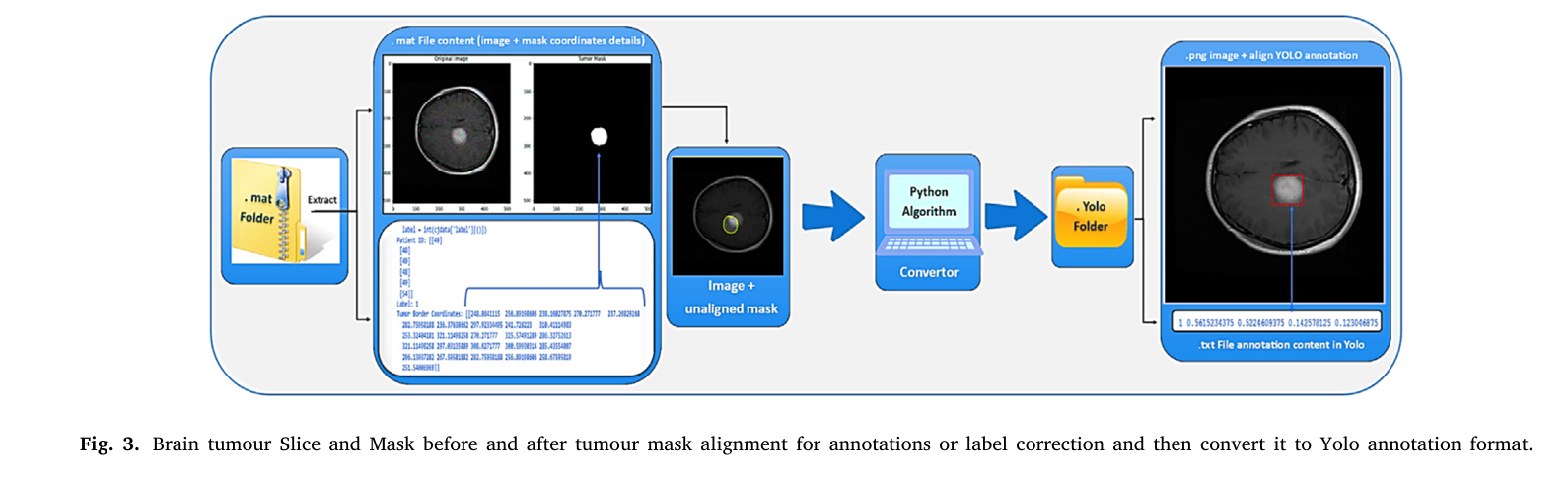

算法1大致展示了如何将.mat文件转换为.png图像,并生成与YOLO兼容的标注。 如图3所示,该转换过程包括提取相关肿瘤掩码、确定边界框坐标,以及对坐标进行归一化处理以适配YOLO输入格式——在该格式中,坐标表示为(类别ID,(中心),

(中心),宽度,高度);图像中的肿瘤边界坐标与肿瘤本身并非精确对齐,因此该算法也对此问题进行了处理。 该预处理过程可确保数据的一致性,并提升模型精确识别肿瘤区域的能力。 算法1为将.mat文件转换为.png图像并生成YOLO格式标注提供了一套系统化流程。该算法首先定义主函数(convert mat to yolo and draw,即.mat转YOLO格式并绘图),该函数接收输入.mat文件、图像输出目录及标签输出目录,并初始化转换过程(步骤2)。 在该函数内部,算法尝试使用h5py库读取.mat文件(步骤4),随后从文件中调用所需变量,包括cidata、label(标签)、pid(患者ID)、image(图像)和tumour mask(肿瘤掩码)(步骤5)。 其中,image变量存储核心图像数据,而tumour mask变量提供用于定位肿瘤区域的分割信息。 接下来,该函数会检查用于保存图像和标签的指定目录是否存在,若不存在则通过os.makedirs函数创建这些目录(步骤6)。 随后通过os.path.splitext函数提取.mat文件的基础名称,以统一文件命名规则(步骤7)。 (步骤8)使用plt.imsave函数将图像数据以.png格式保存,以便简化后续可视化与分析操作。 该算法通过查找肿瘤掩码在x轴和y轴维度上的最小索引与最大索引,确定肿瘤区域的坐标,边界框标注即通过此方式生成(步骤9)。 之后(步骤10),利用这些索引计算出边界框的中心坐标、宽度和高度。 (步骤11)在将格式化标注写入.txt文件前,必须根据图像尺寸对计算得到的数值进行归一化处理,以确保符合YOLO的要求。 (步骤12)该步骤通过捕获异常、检测错误,保障转换过程的稳健性。 算法还定义了另一个函数(process all mat files in a folder,即处理文件夹中所有.mat文件),用于遍历指定文件夹内的所有.mat文件(步骤13)。 在该函数内部,通过循环遍历源目录中的每个文件(步骤14),并为每个.mat文件调用convert mat to yolo and draw函数以进行单独处理(步骤15)。 当所有文件均处理完成后,外部循环终止,转换与标注生成过程至此结束(步骤16)。 这种结构化方法能够确保将.mat文件顺利转换为图像和YOLO标注格式,因此适用于医疗图像分析领域的机器学习应用。图3展示了算法1的处理结果:左侧部分为从.mat文件中提取后、校正前的样本图像,及其掩码与掩码坐标细节;右侧部分为转换为YOLO格式后的图像(含.png文件及其对应的.txt标注文件)。可见,算法1成功实现了坐标与标签的准确对齐和调整。YOLOv8模型与本文提出的模型均需YOLO格式的.txt标签文件,该文件可通过算法1生成。实际数据集必须转换为YOLO格式(包含类别ID、x中心、y中心、宽度、高度,所有参数均为归一化结果),格式转换操作的规则如下:

式1:x坐标归一化,即中心x坐标除以图像宽度)

(式2:y坐标归一化,即中心y坐标除以图像高度)

(式3:宽度归一化,即x轴最大坐标与最小坐标的差值除以图像宽度)

(式4:高度归一化,即y轴最大坐标与最小坐标的差值除以图像高度)

完成必要的预处理后,FBT数据集被划分为两个子集,分别用于模型训练和验证。如图2-(b)所示,训练集包含2452张图像,占数据集总量的80%;验证集包含612张图像,占数据集总量的20%。 这种划分方式可确保模型在多样化的图像子集上进行训练,同时验证集能用于评估模型在未见过的数据上的性能。 需注意的是,该数据集两个子集中的所有图像均配有各自的.txt文件,这些文件以YOLO格式标注的形式记录了对应图像的掩码信息。 ### 算法1:将.mat文件转换为YOLO格式的伪代码

(Algorithm 1: Pseudo code for converting .mat files to YOLO Format)

步骤1 → 开始(Begin)

步骤2 → 定义函数convert_mat_to_yolo_and_draw(mat_file,image_output_dir,label_output_dir)

步骤3 → 尝试(Try):

步骤4 → 使用h5py库加载.mat文件,记为f

步骤5 → 调用以下变量:

- cjdata = f[’cjdata’](数据集核心数据)

- label = int(cjdata[’label’][()])(标签,转换为整数型)

- pid = cjdata[’PID’][()](患者ID)

- image = np.array(cjdata[’image’])(图像数据,转换为numpy数组)

- tumour_mask = np.array(cjdata[’tumour Mask’])(肿瘤掩码,转换为numpy数组)

步骤6 → 使用os.makedirs函数创建image_output_dir(图像输出目录)和label_output_dir(标签输出目录)

步骤7 → 使用os.path.splitext函数从mat_file中提取文件基础名称

步骤8 → 使用plt.imsave函数将图像保存为.png格式

步骤9 → 通过以下方式确定边界框坐标:

- y_indices, x_indices = np.where(tumour_mask)(获取肿瘤掩码中非零值的y轴、x轴索引)

- x_min, x_max = x_indices.min(), x_indices.max()(计算x轴索引的最小值与最大值)

- y_min, y_max = y_indices.min(), y_indices.max()(计算y轴索引的最小值与最大值)

步骤10 → 计算YOLO格式参数:中心x坐标(x_center)、中心y坐标(y_center)、宽度(width)、高度(height)

步骤11 → 将YOLO格式参数写入.txt文件

步骤12 → 捕获异常(若发生任何错误)

步骤13 → 定义函数process_all_mat_files_in_folder(source_folder,image_output_dir,label_output_dir)

步骤14 → 循环:遍历source_folder(源文件夹)中的所有.mat文件

步骤15 → 为每个文件调用convert_mat_to_yolo_and_draw函数

步骤16 → 结束(End)

3.3 模型开发

本研究采用了YOLOv8模型的两个变体:标准YOLOv8x模型以及新开发的轻量级变体——MK-YOLOv8。研究目的是在精准保持实时性能的前提下,对比这两个模型在脑肿瘤检测与分类任务中的表现。

3.3.1

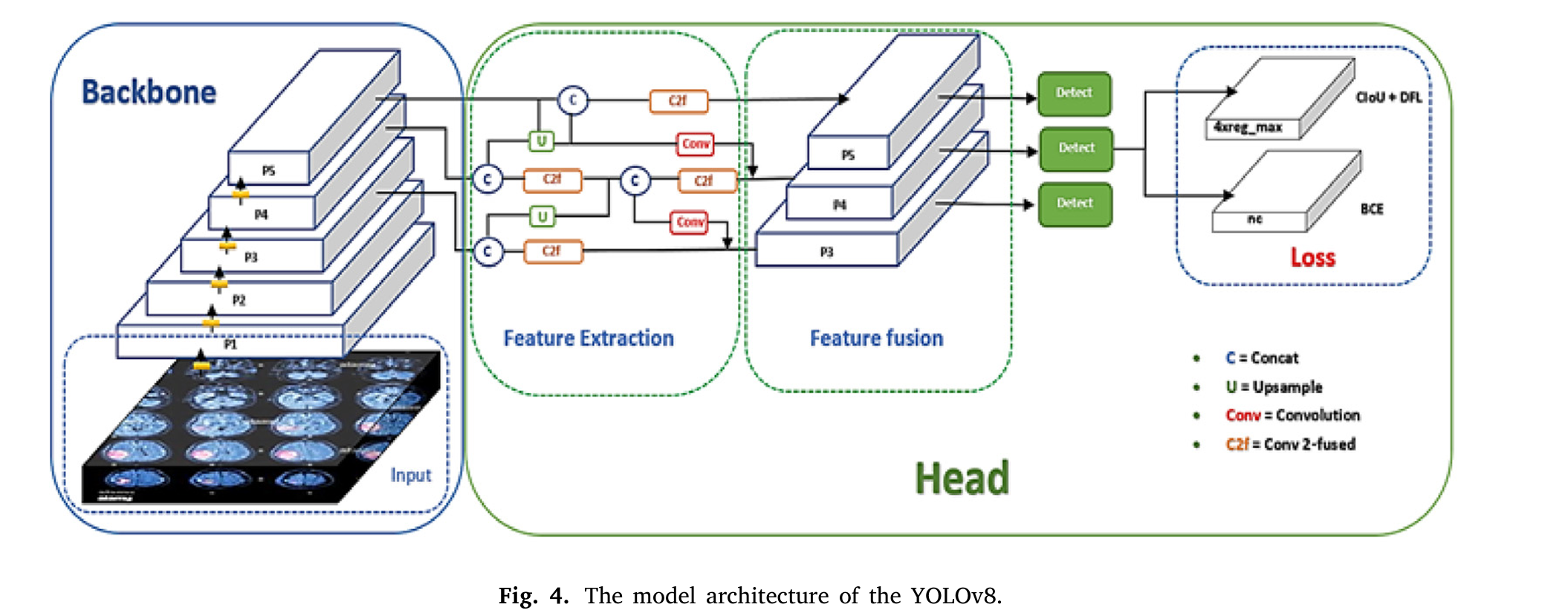

YOLOv8模型架构 YOLO系列计算机视觉检测模型之所以有别于其他模型,核心在于其将准确率与速度出色地结合在一起。作为单阶段检测算法的典型代表,YOLO模型能够快速且精准地实现图像中的目标检测,在实际目标检测场景中展现出极高的实用价值。YOLOv8是YOLO系列中的最新前沿网络,相较于前代版本,其检测准确率和速度均有提升[51]。 基于缩放系数的不同,YOLOv8分为五个版本(n、s、m、l、x)。在YOLOv8后添加不同字母,即可确定所选用的版本,以满足不同检测场景的需求。这些版本的主要差异体现在网络宽度、最大通道数和深度上。从n版本到x版本,四个结构模型的尺寸、参数数量以及每秒千兆浮点运算次数(GFLOPs)均依次增加。这些网络版本可在各类移动平台上部署,但为了尽可能提升可靠性(此处指检测准确性)并实现真正高效的交通标志检测(原文此处为笔误,结合上下文应为“脑肿瘤检测”),我们需要追求最高的检测准确率。 YOLOv8x在COCO数据集上的mAP(0.50–0.95)达到53.9%,准确率在各版本中表现最优,因此成为提升检测准确率的理想选择。然而,相较于前代版本,YOLOv8x的模型尺寸更大、GFLOPs更多,这对模型的快速推理和检测帧率(FPS)产生了不利影响。此外,虽然该模型在嵌入式设备上部署后可实现实时目标检测,但需要特定的硬件支持。同时,YOLOv8x在检测极小目标时准确率不足。 本研究中的实时模型需满足智能医疗系统对检测性能的严格要求,包括能够检测超小、小、中、大等所有尺度的目标,且模型权重需控制在合理范围。因此,研究对检测模型的可扩展性、准确率和效率进行了深入分析,并基于YOLOv8x架构设计了改进模型。 如图4所示,YOLOv8网络由四个主要部分组成:图像输入层、特征融合模块、特征提取网络和检测头。其中,检测头借鉴了YOLOX网络的设计思路,采用解耦头结构,将定位任务与分类任务分离,从而提升对中小目标的检测性能。在输入阶段,YOLOv8会对数据进行预处理;而在数据处理阶段,YOLOv8沿用了YOLOv5的方法,通过随机透视变换、马赛克增强、混合增强(mix-up)和HSV色彩空间增强等手段进一步提升数据多样性。 在YOLOv7模型中,基于扩展高效层聚合网络(E-ELAN)提出的C2f、CBS和SPPF三个模块,为YOLOv8的特征提取提供了思路。在特征融合阶段,YOLOv8采用PAFPN(路径聚合特征金字塔网络)结构构建特征金字塔,以充分融合深层特征与浅层特征的信息。此外,YOLOv8的检测头同样借鉴了YOLOX网络的解耦头设计,将定位与分类任务分离。

3.3.2

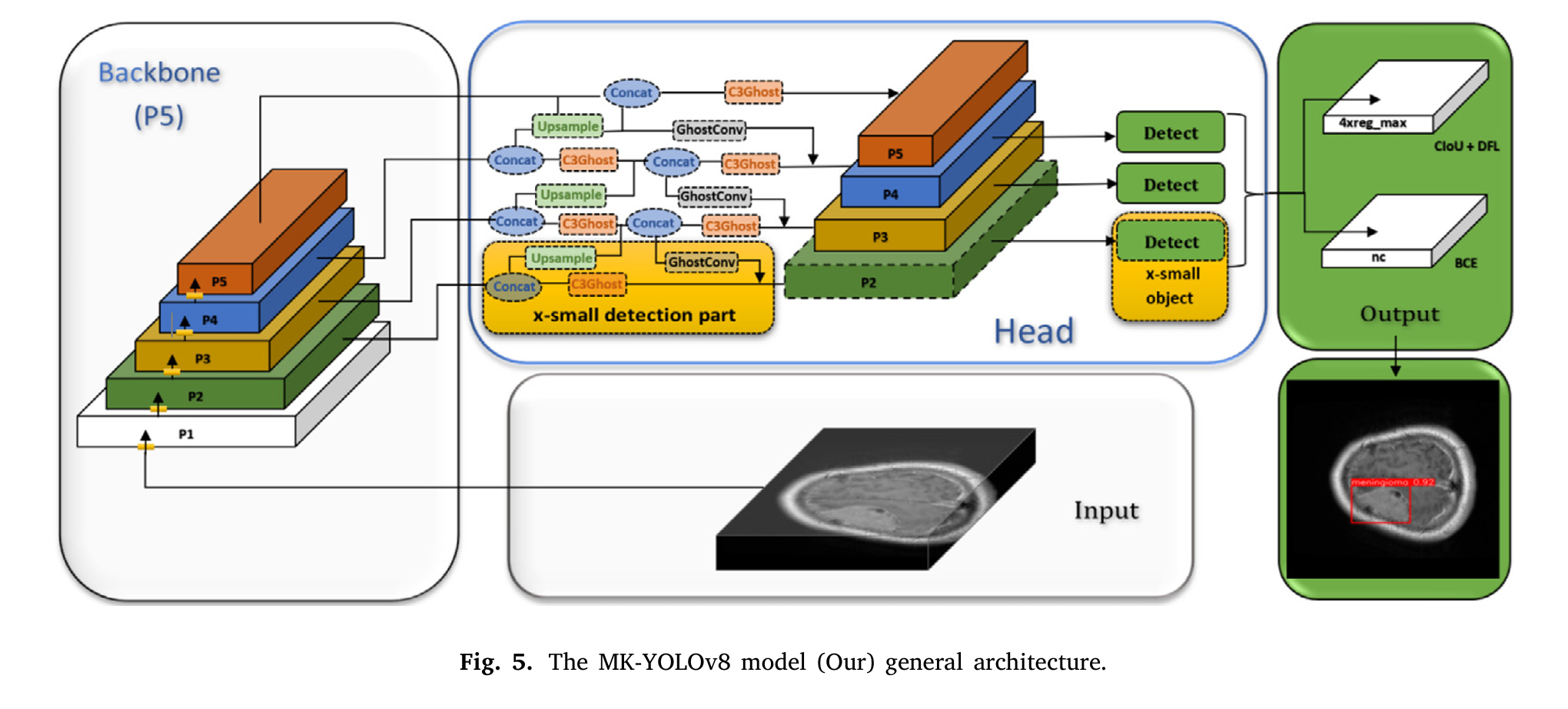

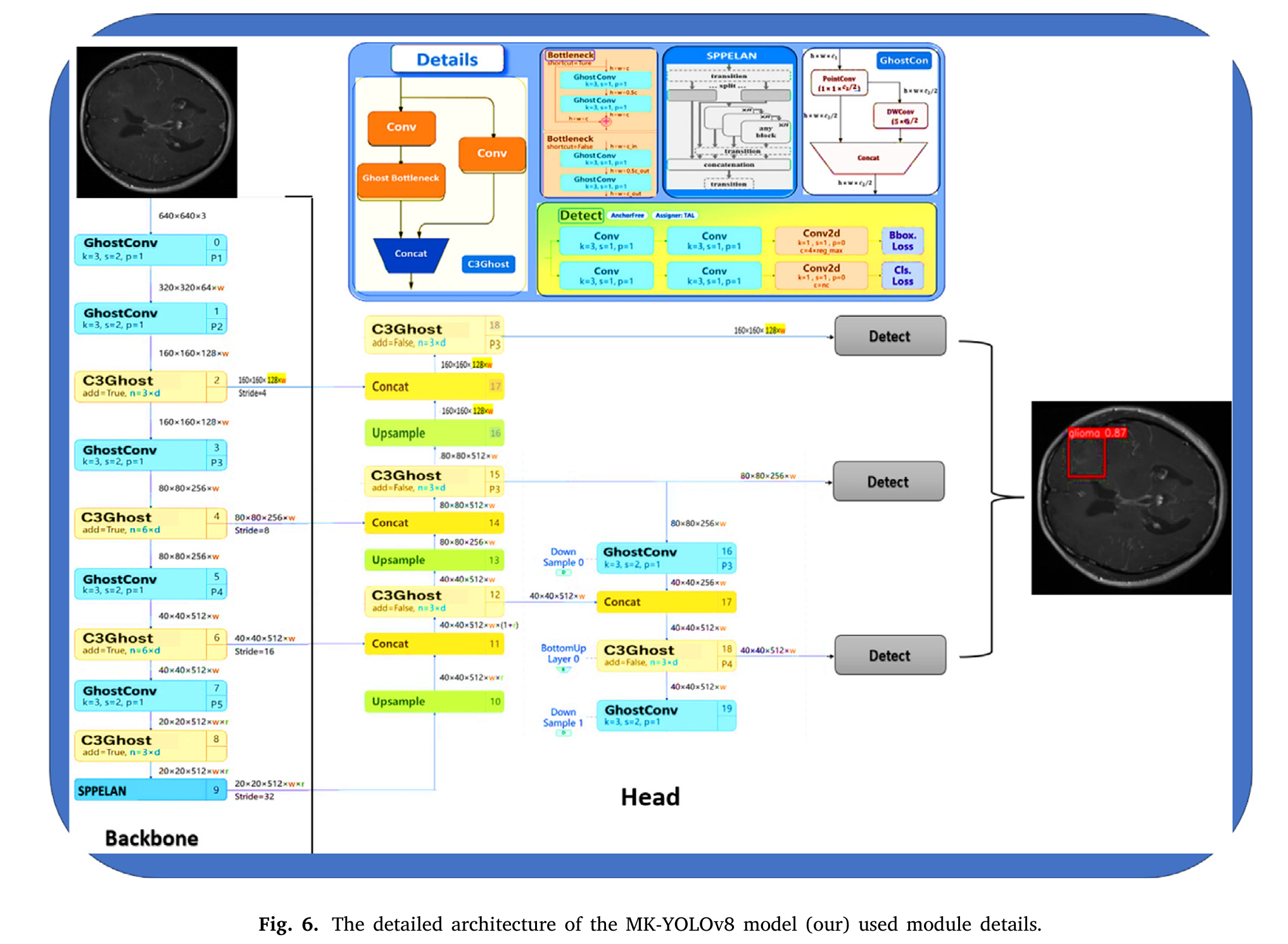

所提MK-YOLOv8模型 图5展示了所提MK-YOLOv8模型的整体框架,包括模型的骨干网络(backbone)和检测头(head),其中检测头由颈部网络(neck)和检测器(detector)组成。要确定肿瘤的位置和类别,需先从输入图像中提取特征,并以这些特征为基础完成定位与分类任务。 相较于标准YOLOv8架构,MK-YOLOv8模型进行了多项改进,以提升对脑MRI图像中极小肿瘤(如超小肿瘤)的检测能力。如图6所示,主要改进包括:

- **Ghost卷积(GhostConv)**:用GhostConv层替代YOLOv8骨干网络中的标准卷积层,在不牺牲特征提取性能的前提下,减少参数数量和计算量。

- **C3Ghost模块**:该模块在保持计算效率的同时,增强了骨干网络提取空间信息的能力。因此,MK-YOLOv8用C3Ghost模块替代了YOLOv8骨干网络和检测头中的所有C2f模块。

- **SPPELAN模块**:将空间金字塔池化特征学习注意力网络(SPPELAN)集成到模型中,以捕捉多尺度特征并提升空间层次结构的特征表示能力——这对于检测不同尺寸的肿瘤至关重要。因此,MK-YOLOv8用SPPELAN模块替代了YOLOv8中的SPPF(空间金字塔池化快速)模块。 SPPELAN模块通过空间金字塔池化(SPP)操作,使网络能够聚合不同尺度的上下文特征,并利用多种池化操作捕捉多尺度空间信息;同时,该模块采用轻量化快速(F)操作优化网络结构,在减少计算开销的同时保留特征表示能力。此外,层聚合(L)操作通过融合多层级特征,进一步提升了特征的层次化表示能力和特征融合效果;注意力网络(AN)的加入则使模型能够更好地聚焦关键特征,从而提升检测与分类性能。因此,SPPELAN模块特别适用于现代YOLO架构中的实时目标检测任务,其集成是MK-YOLOv8模型性能优异的重要原因。在YOLOv8架构中,检测头完全负责预测输入图像中每个目标的边界框和类别概率。

- **超小目标检测层**:为MK-YOLOv8新增了超小目标检测层,以更好地处理极小肿瘤样本——这类样本往往容易被传统模型遗漏。该超小目标检测层通过对低层特征进行上采样,并将其与高层特征拼接,有效提升了检测准确率。

MK-YOLOv8的检测头由六个部分组成,每个部分对应骨干网络输出的一个特征图。检测头前三个部分中的上采样层,能够恢复骨干网络下采样过程中丢失的空间信息,提升特征图的分辨率。上采样后,网络会对特征图进行拼接操作,拼接后的特征图将作为后续层的输入。每个拼接层后均连接一个具有不同通道数的轻量化C3卷积层,对前一层输出的拼接特征图进行处理,随后再连接一个C3Ghost层。 检测头后两个部分的结构顺序为:GhostConv层、拼接(concat)层(将前一层输出与后一层输出拼接)。通过对高层特征与低层特征进行拼接,可将高分辨率的低层特征向上传递至高层特征,从而实现PANet(路径聚合网络)[52]的框架设计。该设计利用多尺度特征的互补优势,提升了目标检测的准确率。卷积层将输入转换为特征图后,拼接层后连接的C3Ghost层会对特征图进一步处理。这一部分融合了来自特征金字塔不同层级(P2、P3、P4)的特征信息,并完成目标检测、边界框预测以及指定类别数量的类别概率预测。 YOLOv8模型默认支持80类目标检测,而MK-YOLOv8仅针对脑肿瘤检测任务的需求,将检测类别数量限制为4类(原文此处应为3类,结合数据集信息应为脑膜瘤、胶质瘤、垂体瘤三类,可能为笔误),以让模型更专注于特定类别的检测。检测头的最后一部分是一个步长为1的检测层,该层在原始分辨率(无下采样)下进行检测,确保检测精度。通过这一架构设计,MK-YOLOv8可移除检测头中针对大目标的检测部分,专注于超小、小、中三类目标的检测与识别。 C3Ghost模块借鉴了CSPNet(跨阶段部分网络)[53]的架构,结合GhostConv实现对图像的卷积操作。在单个阶段中,C3Ghost模块将骨干层特征图分为两部分,从而实现低成本的特征提取;同时,在信息融合过程中减少了特征的冗余性。下一部分将详细介绍该模块的具体结构。 本研究提出的改进模型基于YOLOv8x构建,首先用GhostConv和C3Ghost模块替代了YOLOv8x中的所有卷积层、瓶颈层(bottleneck)和C2f模块,以完成特征提取任务(图6展示了原有模块的参数和功能)。随后,为提升检测器对超小目标和远距离小目标的识别能力,需在检测器中新增一个超小目标检测层,具体可通过添加具有指定内部参数值和功能的代码实现。 如图5所示,超小目标检测部分包含一个上采样层,该层采用“最近邻插值”(nearest-neighbour interpolation)方法,将输入数据的尺寸放大2倍(缩放系数为2)。此外,拼接层将来自层1和层2的特征图进行融合,提升了模型捕捉多尺度空间信息和上下文信息的能力。该方法既保留了浅层特征中的高分辨率信息,又融合了深层特征中的抽象特征,从而提升了网络在复杂多样数据集中对极小肿瘤的识别准确率。 如图5所示,超小目标检测部分的最后一层为C3Ghost层。图中黄色虚线框标注了超小目标检测层及其检测部分的具体连接方式和功能,并说明了该检测层在模型检测头中的添加位置以及与骨干网络的连接方式。 最后,各尺度的特征图会被输入到检测模块(Detect module)。该方法不仅有助于超小目标的检测,还能提升对极小目标的高分辨率检测效果。同时,MK-YOLOv8在保证检测准确率的前提下,通过减少计算量和参数数量实现了模型压缩,这对于处理复杂的脑肿瘤检测场景具有重要意义。

3.3.3 C3Ghost与GhostConv操作

如图6“细节(Details)”框中的C3Ghost模块结构图所示,C3Ghost模块是一种改进的卷积结构,它在传统卷积块注意力模块(CBAM)和C3(跨阶段部分网络)架构的基础上进行优化,旨在减少卷积神经网络中特征提取的冗余性并提升计算效率。 C3Ghost模块通过融合GhostNet的设计思路,将标准卷积分解为高效卷积操作和低成本线性变换,采用“分割-变换-融合”(split-transform-merge)策略,在降低计算成本的同时生成与标准卷积相似的特征图。其数学表达式如下:

其中,

表示轻量级线性变换,

为主要的卷积特征提取器,

为最终输出。

用于控制Ghost特征的贡献度,通常设置为一个能平衡特征表示能力与计算效率的值。该模块在加入GhostConv层以提升性能和效率的同时,保留了原始C3模块的核心特征(如瓶颈结构和跨层跳跃连接),使其非常适合在资源受限设备上运行的轻量级模型[14]。 GhostConv模块通过生成冗余但富含信息的特征图,以更低的计算成本替代了标准卷积。具体而言,GhostConv将输入特征图

分为两个独立分支:

- 第一个分支执行常规卷积操作: 其中,

为可学习卷积核,

表示卷积运算。

- 第二个分支执行一系列轻量级操作(如深度可分离卷积或线性变换): 其中,

为线性映射函数。

随后,对两个分支的输出结果进行拼接,得到最终的增强特征图: 与标准卷积相比,该设计在显著减少参数数量和浮点运算次数(FLOPs)的同时,仍能保持相当的特征表示能力。这一特性对于边缘设备上的实时目标检测与分类任务尤为重要——在这类任务中,平衡准确率与速度至关重要。

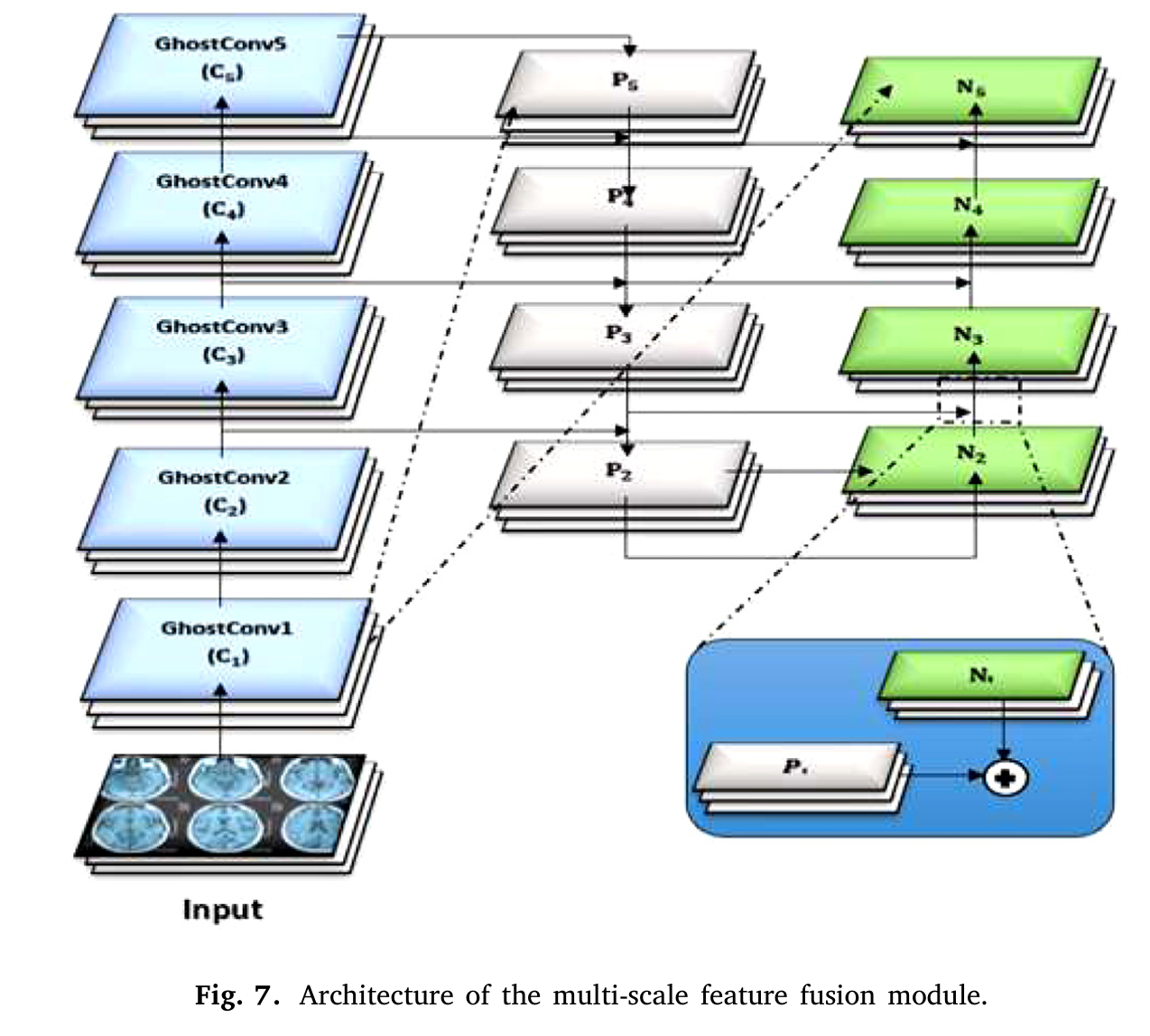

3.3.4 多尺度特征融合

SPPELAN与Ghost模块的集成 将多尺度特征融合(MSFF)架构与基于GhostConv模块的空间金字塔池化特征学习注意力网络(SPPELAN)相结合,构建了一个用于深度学习网络多尺度表示学习的创新性框架。 该框架的核心是SPPELAN模块(如图6所示),其通过创新性地融合空间金字塔池化与注意力机制,实现了空间层次结构的捕捉和特征表示能力的提升。SPPELAN将输入特征图在不同空间维度上分解为更小的片段,生成多层级特征描述子,这些描述子经有效融合后可形成丰富的特征表示。该方法使模型能够处理不同尺寸的图像,且不丢失关键空间上下文信息。此外,SPPELAN中的注意力机制能让模型聚焦于图像中最相关的区域,减少非关键背景元素的干扰。因此,SPPELAN能够灵活捕捉复杂的空间关联关系,并适应不同尺度的目标,从而提升模型对复杂特征的区分能力。 MSFF架构则通过引入Ghost模块,有效优化了特征提取过程,与SPPELAN的优势形成互补。传统卷积操作虽性能强大,但往往会导致计算量过大和特征冗余问题。Ghost模块通过简单的线性变换生成“Ghost特征”,能够在不消耗大量计算资源的情况下,有效模拟原始特征的表示效果。 如图7所示,MSFF架构将GhostConv模块嵌入多尺度融合框架中,在保留关键语义信息和空间信息的同时,对不同分辨率的特征图进行整合与优化。该设计不仅减少了模型所需的参数数量,还提升了处理速度,因此特别适用于边缘计算平台和移动设备应用场景。 SPPELAN与Ghost增强型MSFF模块的结合,形成了一种高效的多尺度特征学习架构,在各类视觉检测任务中实现了性能与计算效率的良好平衡。

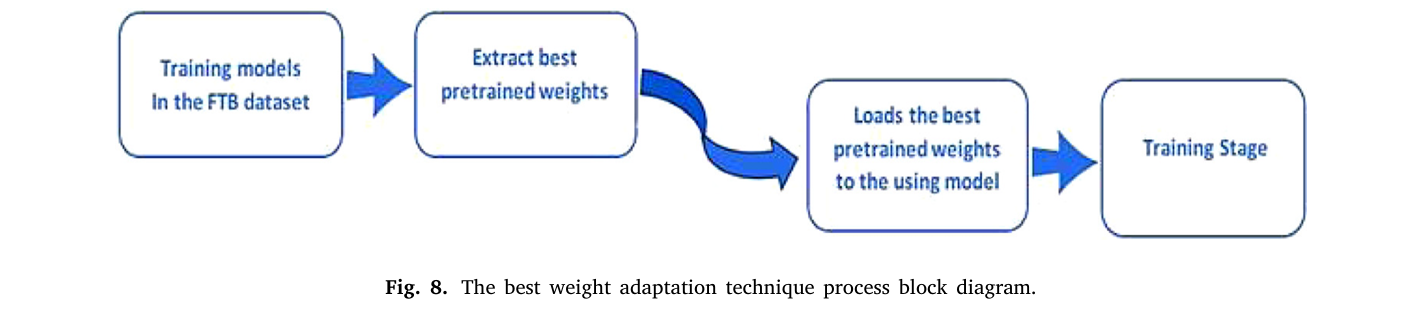

3.4 最佳权重自适应技术(BWAT)

最佳权重自适应技术(BWAT)可提升模型在小规模数据集上的泛化能力。如图8所示,BWAT利用来自大规模数据集的预训练权重,并将其适配到目标数据集,显著提升了模型在FBT数据集上的性能。 使用BWAT的优势包括:

- **提升准确率**:通过以训练良好的模型为初始基础,BWAT有助于模型更快收敛,并实现更高的检测精度。

- **缩短训练时间**:由于模型以预训练权重为起点,所需的训练时间大幅减少。

- **降低计算成本**:BWAT使模型无需大量计算资源即可表现出优异性能。本研究中,所有使用的模型均采用BWAT技术训练了100个epoch(轮次)。训练初期的10,000次迭代使用Adam优化器,后续迭代则采用随机梯度下降(Stochastic Gradient Descent, SGD)对模型进行微调。

3.5 评估指标

为评估模型性能,采用了以下指标:

- **精确率(Precision)**:用于评估模型阳性预测结果的准确性,计算方式为真阳性(True Positives, TP)与真阳性、假阳性(False Positives, FP)总数的比值。

- **召回率(Recall)**:用于衡量模型识别真阳性样本的能力,计算方式为真阳性与真阳性、假阴性(False Negatives, FN)总数的比值。 - **F1分数(F1-Score)**:作为精确率与召回率的调和平均数,可对两个指标进行均衡衡量。

- **平均精度均值(Mean Average Precision, mAP)**:用于评估模型在不同交并比(Intersection over Union, IoU)阈值下的整体检测准确率,常用指标包括mAP(0.50)和mAP(0.50–0.95)。 通过全面评估模型在不同肿瘤类型上的性能,这些指标确保了模型在临床应用中的适用性。

3.5.1 混淆矩阵

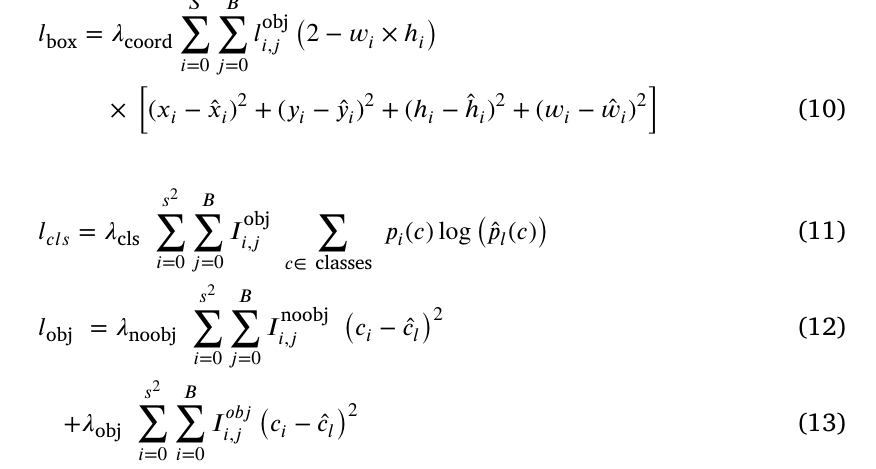

这些指标可反映所提模型的精确性与不精确性。混淆矩阵中的元素(i, j)分别表示实际属于类别(i)但被预测为类别(j)的样本比例。损失函数用于优化模型训练阶段,以下是用于减少损失值的计算公式:

其中,

代表分类损失,

代表置信度损失,

代表边界框回归损失。各类损失的计算公式如式(10)–(13)所示:

其中,为位置损失权重,

为分类损失权重;

、

为目标实际中心坐标,

、

为目标实际宽度和高度。当锚框位于包含目标的(i, j)位置时,

设为1,否则设为0。

为目标属于某一特定类别的概率,

为目标的实际类别标签值,两者的维度均与类别总数C一致。

3.5.2 精确率

该指标通过式(13)计算真阳性检测结果与真阳性、假阳性检测结果总数的比值,以此评估边界框(box)预测的精确性。

3.5.3 召回率

该指标通过式(14)计算真阳性检测结果与真阳性、假阴性检测结果总数的比值得出。

其中,式(13)和式(14)中的(假阳性)和

(真阳性)分别表示假阳性值和真阳性值。 **平均精度均值(mAP):mAP(0.5)与mAP(0.5−0.95)** 指标mAP(0.5)表示交并比(IoU)阈值为0.5时的平均精度均值;mAP(0.5−0.95)表示在IoU阈值从0.5到0.95的范围内计算得到的平均mAP值,两者均通过式(15)计算得出。

其中,N为类别数量,

代表第K类的平均精度。

3.5.4 F1-置信度曲线

该曲线以图形形式展示了目标检测置信度阈值与F1分数之间的关系。通过F1-置信度曲线分析不同置信度水平下召回率与精确率的权衡关系,有助于明确模型在不同置信度设置下的性能表现。

4. 结果分析(Results analysis)

本节对所提出的MK-YOLOv8模型在MRI图像脑肿瘤检测与分类任务中的性能进行了全面分析,并基于Figshare脑肿瘤(FBT)数据集将其结果与基准模型YOLOv8x进行了对比。 在FBT数据集上,先加载模型的预训练权重,提取最优预训练权重,再将其用于模型训练阶段 图8 最佳权重自适应技术(BWAT)流程框图

4.1 初步研究(Initial study)

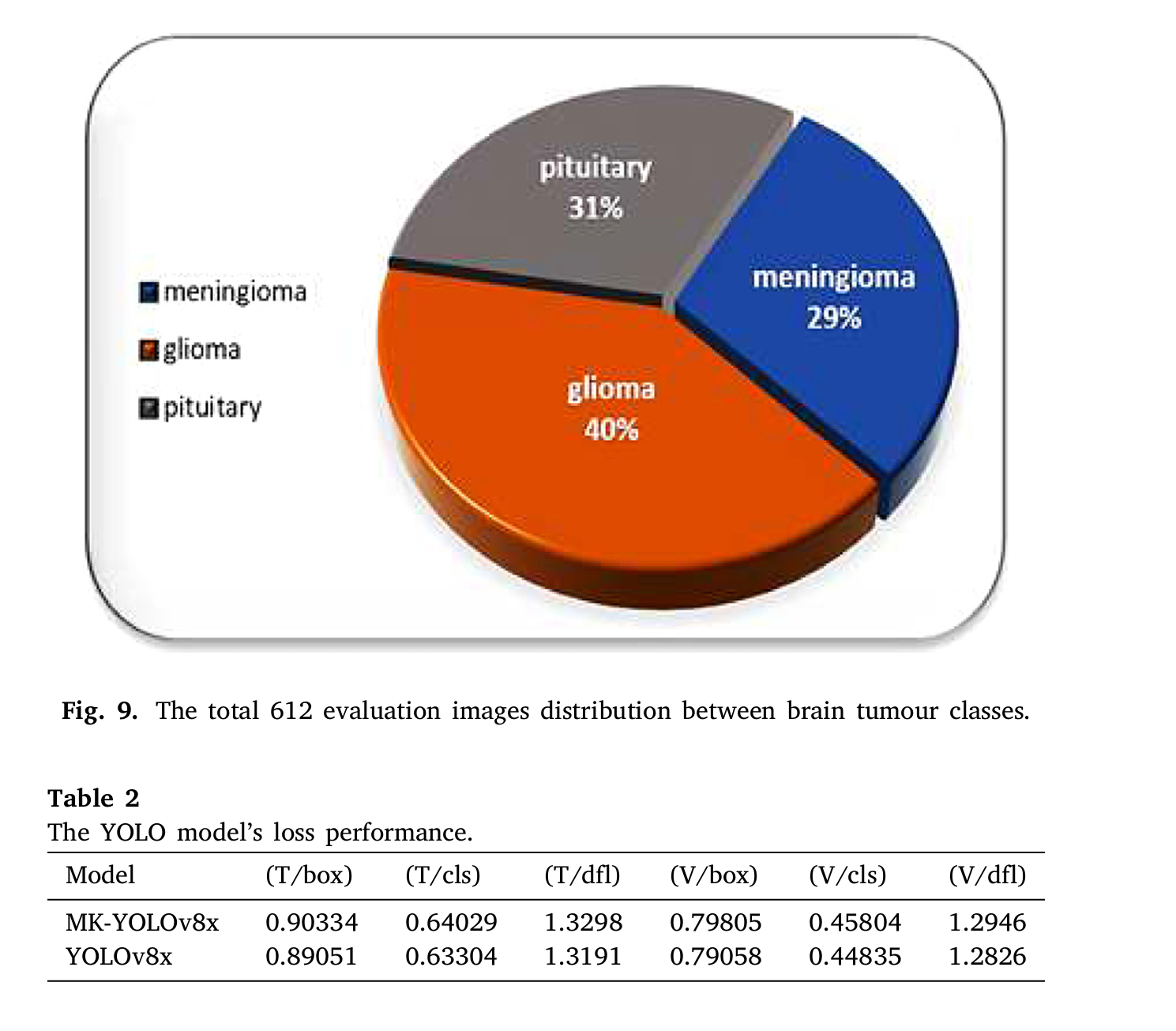

Kaggle平台可提供高性能图形处理器(GPU),这类设备对于训练深度神经网络模型等计算密集型任务至关重要。平台提供的GPU型号包括英伟达Tesla P100,每台设备的GPU内存约为15.90 GB。此外,为P100型号GPU分配的中央处理器(CPU)资源为双核,同时配备13 GB内存;这些资源足以支持大规模机器学习实验的开展。研究已将YOLOv8的GitHub代码仓库克隆到Kaggle环境中。如第3节所述,本研究使用包含612张脑肿瘤图像的数据集对模型进行评估。图9展示了这612张验证图像在FBT数据集三类肿瘤中的分布情况。 垂体瘤:31% 脑膜瘤:29% 胶质瘤:40% 图9 612张评估图像在不同脑肿瘤类别中的分布 在训练阶段,研究采用BWAT技术对所用模型进行了100个epoch的训练,并对超参数进行了调优。所选超参数中,初始学习率(lr)设为0.01,动量设为0.937,权重衰减设为0.0005,图像尺寸(imgsz)设为512×512,批处理大小(batch size)设为16;优化器选择“自动(auto)”模式,系统会根据批处理大小和数据集特性自动确定最优优化器。训练初期的前10,000次迭代使用Adam优化器,后续训练阶段则采用随机梯度下降(SGD)优化器。

4.2 损失性能(Loss performance)

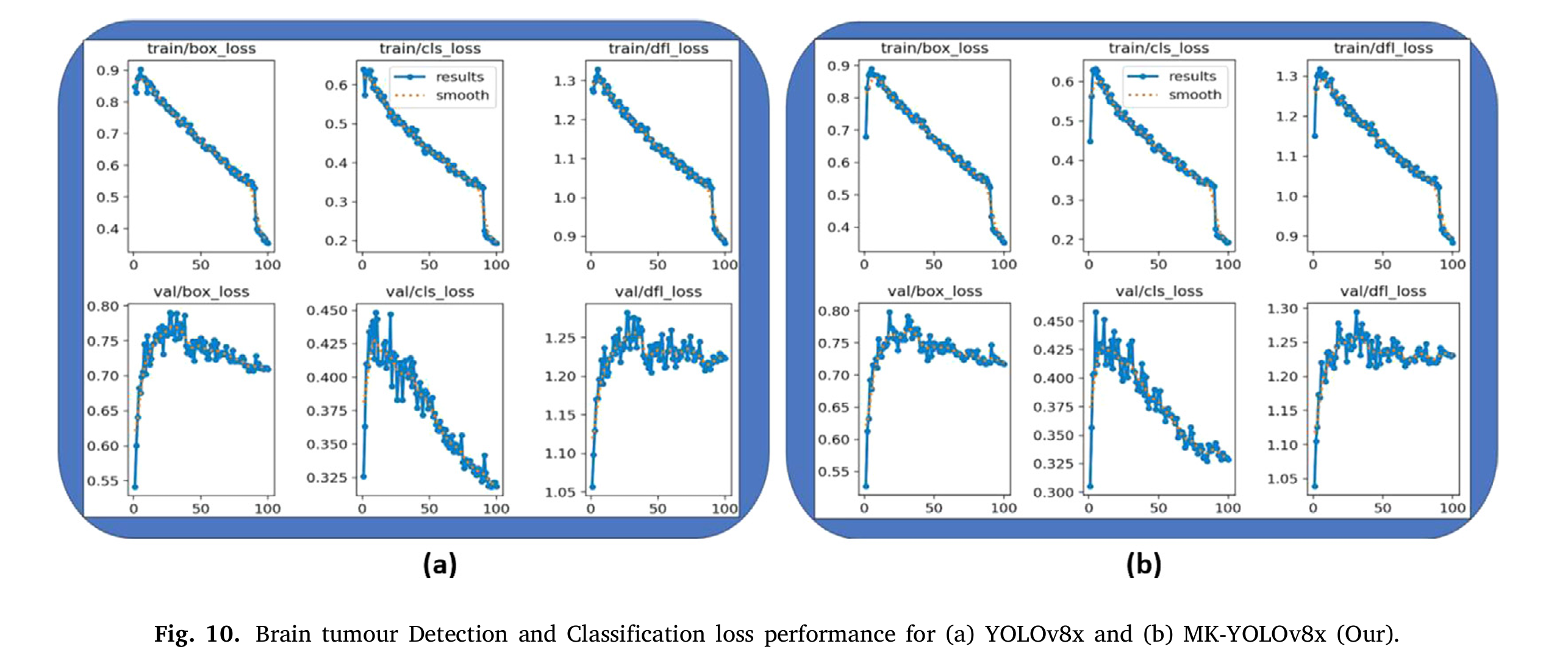

研究通过边界框损失、目标检测损失和分类损失三个指标评估了模型在训练过程中的性能。表2对比了YOLOv8x与MK-YOLOv8x模型的损失值。其中,MK-YOLOv8x模型(本文所提模型)的训练边界框损失(T/box)为0.90334,比YOLOv8x模型(0.89051)高出0.01283。此外,在训练分类损失(T/cls)和训练分布焦点损失(T/dfl)方面,MK-YOLOv8x模型与YOLOv8x模型也存在差异:MK-YOLOv8x的T/cls值为0.64029、T/dfl值为1.3298,而YOLOv8x的T/cls值为0.63304、T/dfl值为1.3191。在验证损失方面,MK-YOLOv8x模型在验证边界框损失(V/box)、验证分类损失(V/cls)和验证分布焦点损失(V/dfl)上的数值均略高于YOLOv8x模型。为清晰呈现所用模型的损失差异,图10以图形化方式展示了表2中的数据。为保证内容简洁,本文不再赘述其他分析结果。

4.3 评估指标结果(Evaluation matrix results)

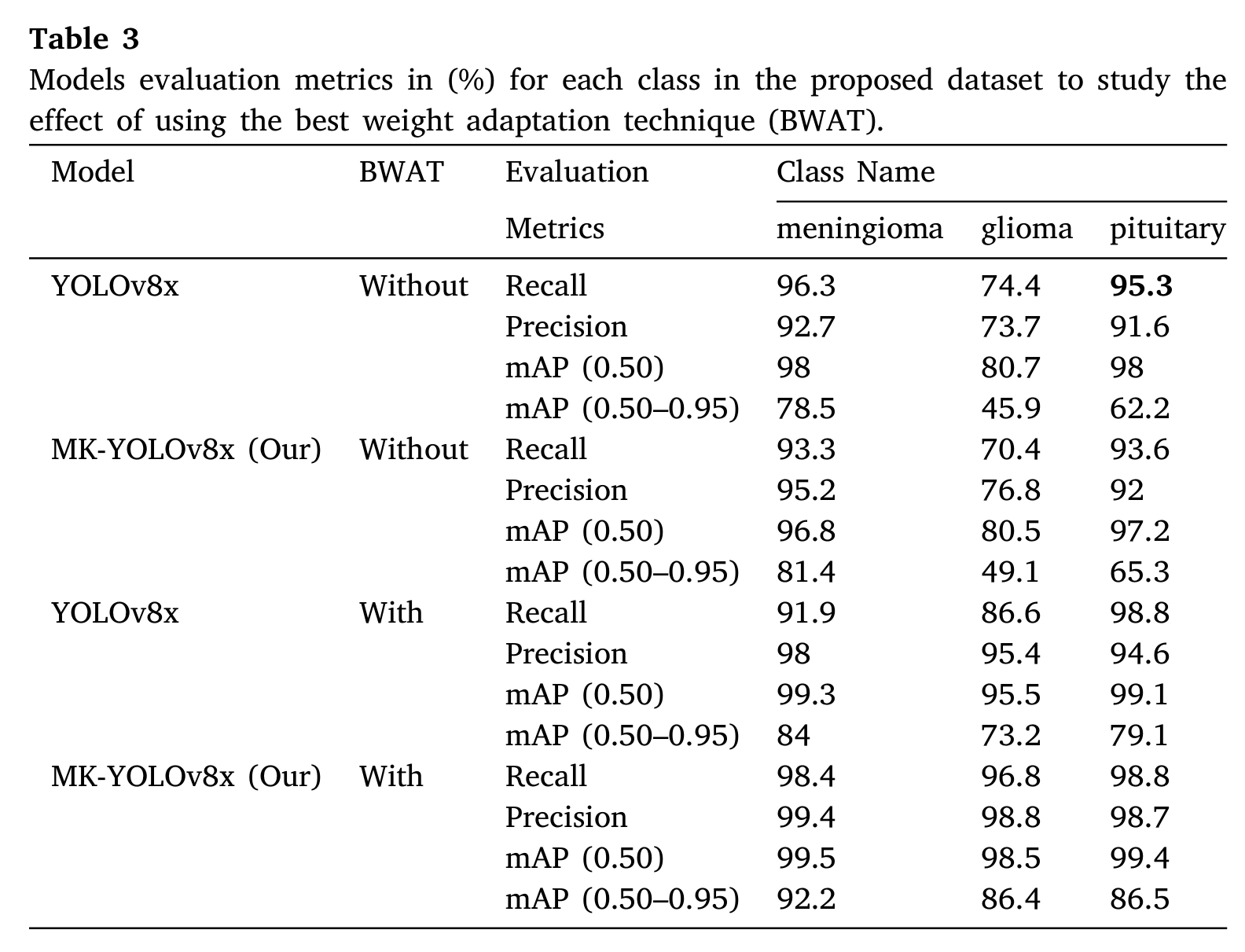

研究通过精度(Precision)、召回率(Recall)和平均精度均值(mAP)三个指标评估了两种模型的性能。表3所示结果表明,在脑膜瘤、胶质瘤、垂体瘤三类脑肿瘤的检测与分类任务中,MK-YOLOv8x模型的性能均优于YOLOv8x模型。研究同时采用了“使用最佳权重自适应技术(BWAT)”和“不使用BWAT”两种实验设置,基于前文所述的评估指标开展对比实验。 结果显示,在不使用BWAT的情况下,两种模型对脑膜瘤和垂体瘤的检测效果较好,精度值均超过90%;但对胶质瘤的检测性能较差,尤其是在召回率和mAP(0.50–0.95)指标上表现明显。其中,YOLOv8x模型在不使用BWAT时,胶质瘤检测的mAP仅为45.9%。 应用BWAT后,两种模型的各项指标均得到显著提升。例如,YOLOv8x模型对胶质瘤的检测精度从73.7%提升至95.4%,召回率从74.4%提升至86.6%。而本身性能略优于YOLOv8x的MK-YOLOv8x模型,在应用BWAT后,对所有肿瘤类别的检测精度和召回率均接近完美水平:mAP(0.50)值超过99%,且胶质瘤检测的mAP(0.50–0.95)从49.1%大幅提升至86.4%。 总体而言,MK-YOLOv8x模型与BWAT的结合实现了最佳性能,尤其在检测难度较大的胶质瘤任务中,精度、召回率和mAP指标均得到显著提升。这些结果表明,BWAT在增强模型对不同肿瘤类型的泛化能力以及在不同IoU阈值下的性能方面具有重要作用,同时也凸显了MK-YOLOv8x模型的高效性——尤其是与BWAT结合时,该模型成为脑肿瘤临床精准诊断的理想选择。 表3 基于所提数据集,在有无最佳权重自适应技术(BWAT)条件下,各模型针对不同类别的评估指标(单位:%)

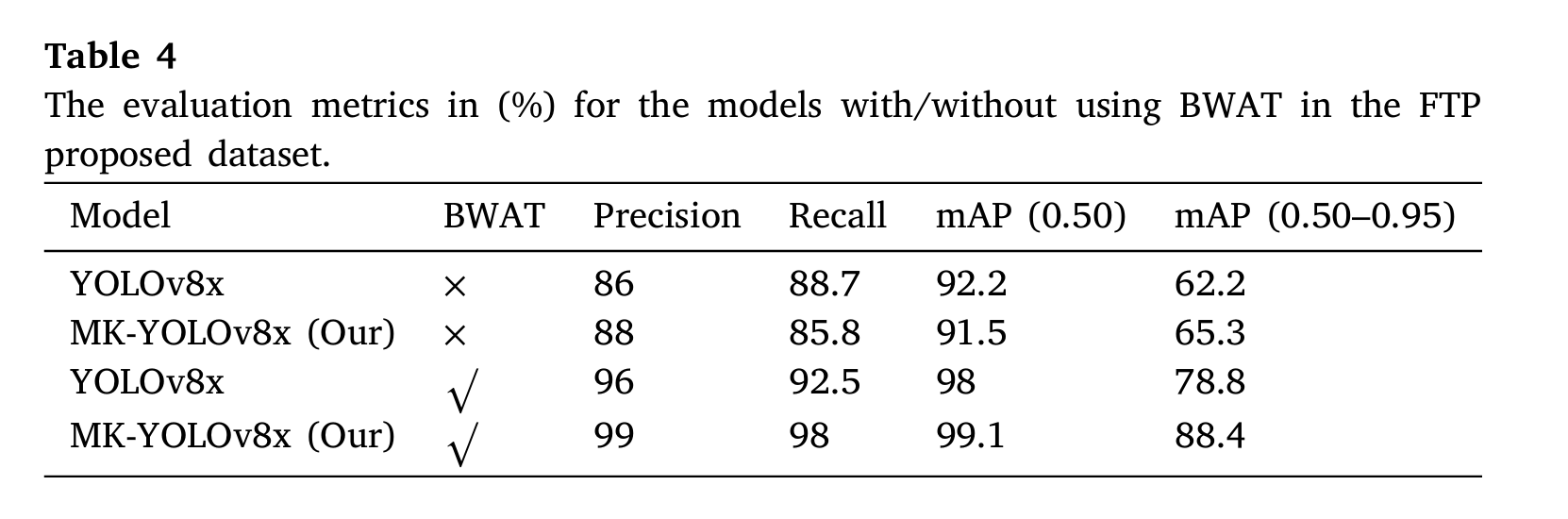

表4基于所提FBT数据集,对比了有无应用权重自适应技术(BWAT)时,YOLOv8x与MK-YOLOv8x模型在所有肿瘤类别上的综合性能。

不使用BWAT时,YOLOv8x模型的召回率为88.7%、精度为86%,mAP(0.50)为92.2%,mAP(0.50–0.95)为62.2%;即使不使用BWAT,MK-YOLOv8x模型的性能仍略优于YOLOv8x,其召回率为85.8%、精度为88%,mAP(0.50)和mAP(0.50–0.95)分别为91.5%和65.3%。这一结果表明,MK-YOLOv8x模型在基准性能上优于YOLOv8x,但两种模型在更严格的IoU阈值(如mAP(0.50–0.95))下均表现出一定局限性。 应用BWAT后,两种模型的性能均有显著提升:YOLOv8x模型的精度、召回率和mAP(0.50)分别提升至96%、98%和98%,mAP(0.50–0.95)提升至78.8%,检测性能和泛化能力均得到改善;MK-YOLOv8x模型的受益更为明显,其精度接近完美水平(99%),召回率为98%,mAP(0.50)和mAP(0.50–0.95)分别达到99.1%和88.4%。这些结果表明,BWAT在增强目标检测性能(尤其是在需要高精度和复杂条件下泛化能力的任务中)方面效果显著,且MK-YOLOv8x与BWAT的结合能实现所有评估指标下的最佳综合性能。

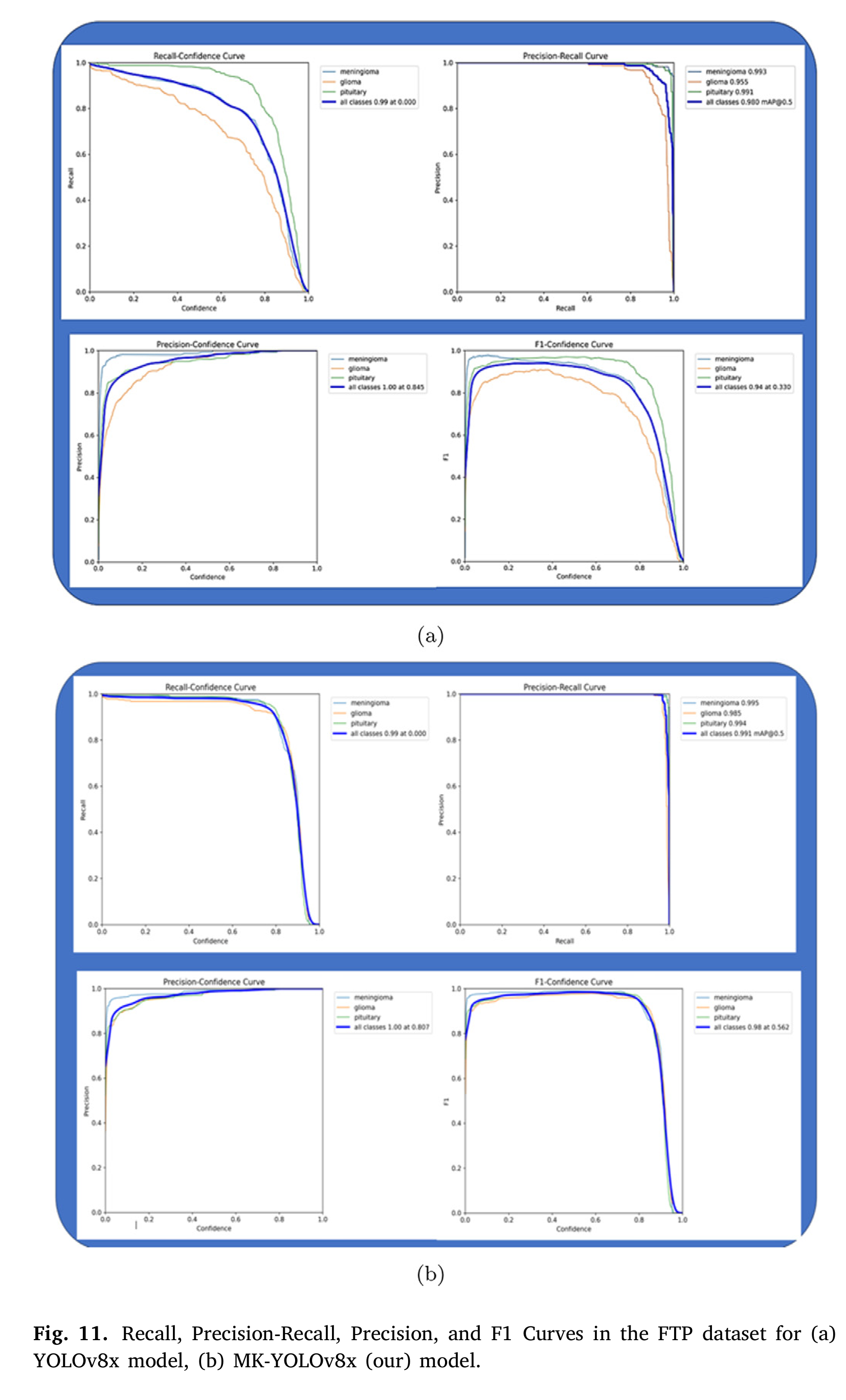

图11基于FBT数据集,通过召回率-置信度、精度-召回率、精度-置信度和F1-置信度四条曲线,对YOLOv8x模型及其变体MK-YOLOv8x模型进行了对比分析。该图展示了两种模型在脑膜瘤、胶质瘤、垂体瘤三类肿瘤分类任务中的性能:子图(a)为YOLOv8x模型的指标曲线,虽表现出较好的精度和召回率,但不同类别间的性能存在一定差异;子图(b)为MK-YOLOv8x模型(本文所提)的指标曲线,在所有评估指标上均表现出更高的稳定性和置信度。这些结果表明,MK-YOLOv8x模型在泛化能力和鲁棒性方面更具优势,尤其适用于医学影像场景下的多类别检测与分类任务。

4.4 检测时间与速度(Detection time and speed)

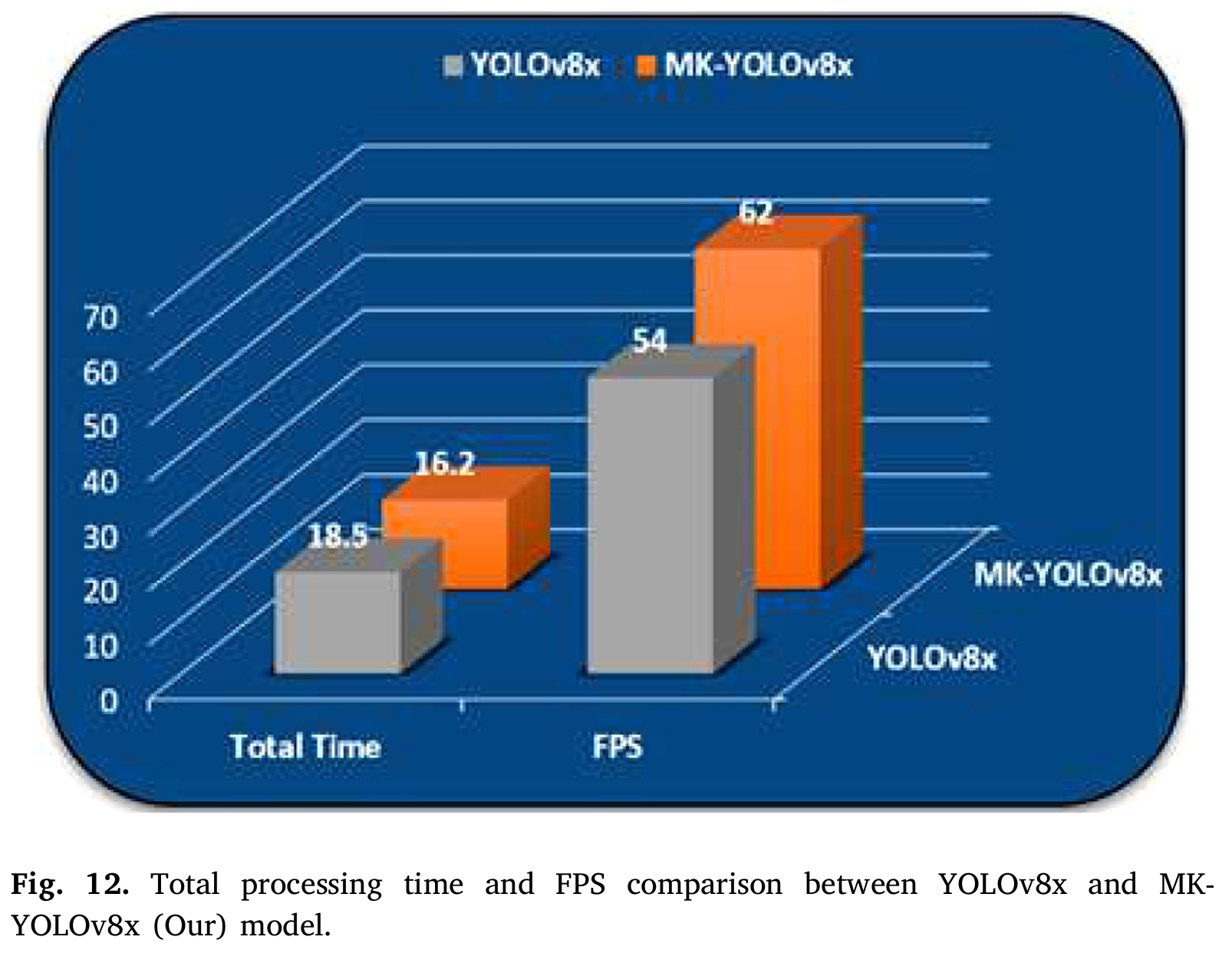

为评估模型在实时应用场景中的适用性,研究计算了YOLOv8x与MK-YOLOv8x模型的检测时间。结果显示,MK-YOLOv8x模型处理单张图像的总时间为16.2毫秒,而YOLOv8x模型为18.5毫秒;这意味着MK-YOLOv8x的速度提升了约14.2%,其帧率(FPS)达到62帧/秒,高于YOLOv8x的54帧/秒(见图12)。 这种性能提升可归因于MK-YOLOv8x模型的优化架构设计,例如引入了GhostConv和C3Ghost模块——这些模块在保证高检测精度的同时,有效缩短了推理时间。结果表明,MK-YOLOv8x模型更适用于对检测速度有严格要求的实时临床应用场景。

4.5 混淆矩阵(Confusion matrix)

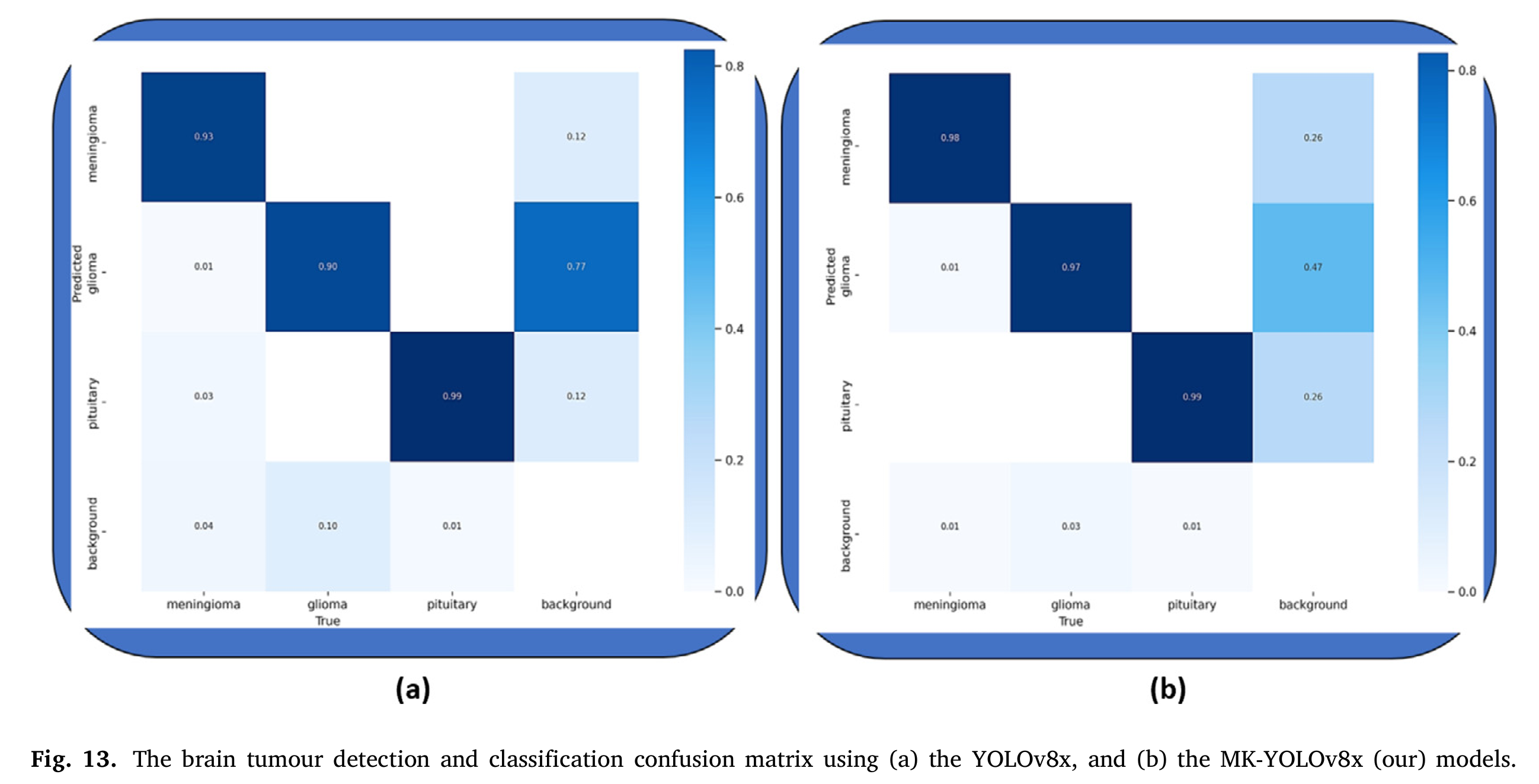

图13展示了两种模型的混淆矩阵。结果显示,MK-YOLOv8x模型对胶质瘤类别的误分类率更低,仅为0.01,而YOLOv8x模型为0.12。两种模型在脑膜瘤和垂体瘤的识别任务中均表现良好,其中MK-YOLOv8x对这两类肿瘤的分类精度略高。 然而,两种模型在将背景区域误分类为肿瘤方面仍存在改进空间——尤其在背景类别中,MK-YOLOv8x模型会将部分区域误分类为脑膜瘤或胶质瘤。这一问题表明,未来需进一步优化模型以降低背景噪声干扰,提升对所有肿瘤类型的检测精度。

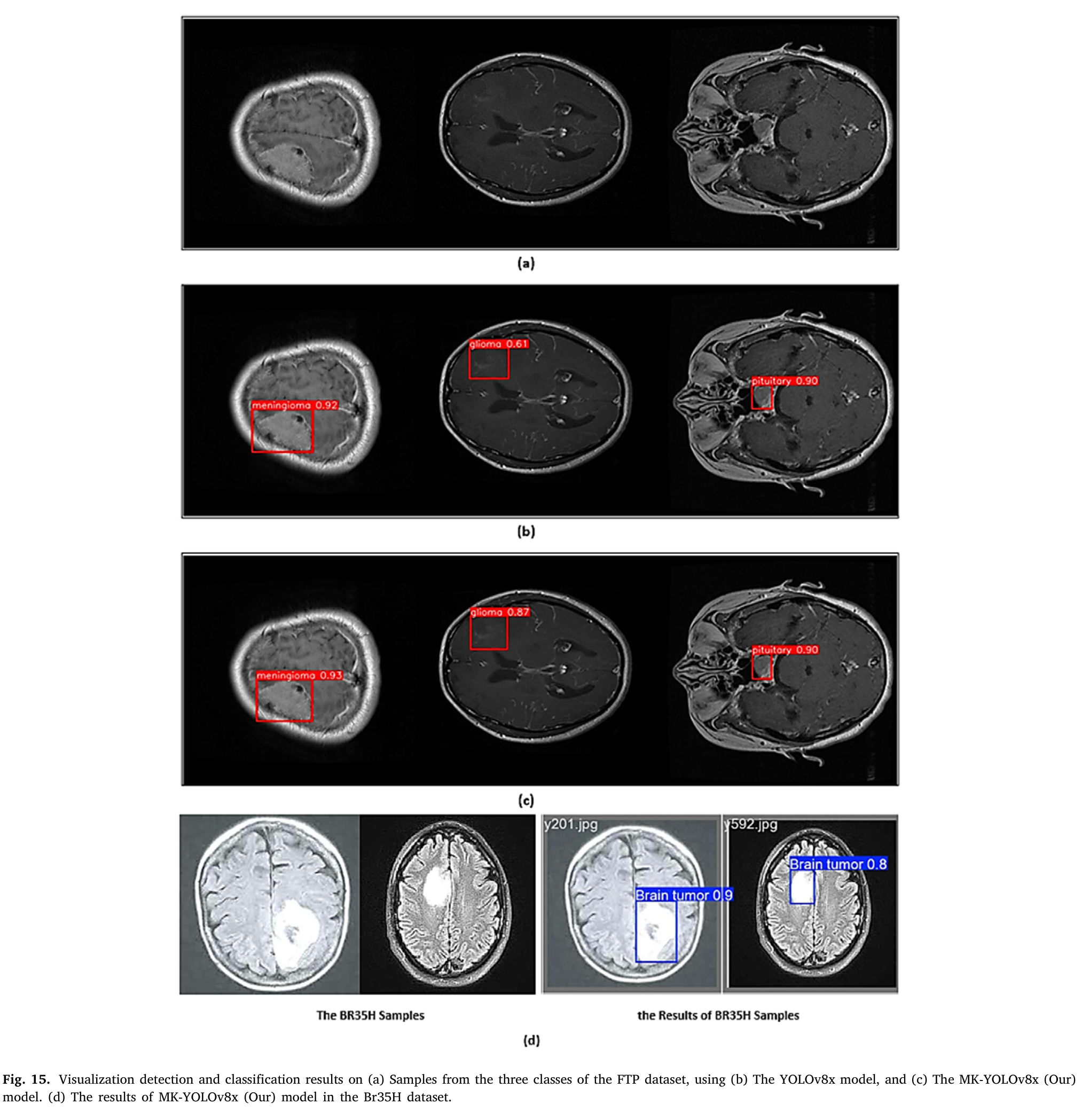

4.6 检测结果可视化(Visualization of detection)

为进一步验证两种模型的性能,图15展示了在FBT和Br35H数据集上脑肿瘤检测与分类结果的可视化示例。所选图像涵盖了不同大小和位置的肿瘤,结果显示,MK-YOLOv8x模型在小型、难检测肿瘤的精准识别任务中始终优于YOLOv8x模型,这证实了MK-YOLOv8x模型的适应性、泛化能力以及更优的检测性能——尤其在小型肿瘤检测任务中表现突出。

5. 讨论(Discussion)

本研究结果表明,在基于MRI图像的脑肿瘤分类与定位任务中,所提出的MK-YOLOv8模型在检测精度和速度方面均显著优于标准YOLOv8x模型。本节将探讨主要研究发现及其对实际临床应用的意义。

5.1 性能提升(Performance improvements)

MK-YOLOv8模型在所有肿瘤类别的精度(Precision)、召回率(Recall)和平均精度均值(mAP)上均实现了显著提升,尤其是在结合最佳权重自适应技术(BWAT)后,提升效果更为明显。在YOLOv8架构中融入Ghost卷积(GhostConv)和C3Ghost模块,大幅降低了模型的计算复杂度,使其能够以高精度检测小型和超小型目标。这一改进对于脑肿瘤检测具有重要意义——小型脑肿瘤往往难以通过传统方法或资源消耗较高的大型模型识别,而MK-YOLOv8模型恰好解决了这一难题。

超小目标检测层的引入,进一步增强了模型对超小型肿瘤样本的检测能力。在脑肿瘤检测中,小型肿瘤易被缺乏特定检测能力的模型遗漏,而该特性恰好解决了这一核心挑战。

研究结果还表明,BWAT技术在提升MK-YOLOv8模型对FBT这类相对小型数据集的泛化能力和性能方面发挥了关键作用。通过利用最优预训练权重并在目标数据集上进行微调,BWAT不仅帮助模型实现了更高的精度和召回率,还缩短了训练时间、降低了计算成本。尤其是在胶质瘤检测性能上的大幅提升,进一步验证了BWAT在脑肿瘤检测这类特定领域应用中的有效性。

5.2 对实时临床应用的适用性(Suitability for real-time clinical applications)

与YOLOv8x模型(18.5毫秒)相比,MK-YOLOv8模型将单张图像的处理时间缩短至16.2毫秒,这一结果证实其更适用于实时应用场景。在医疗环境中,及时诊断对治疗效果具有重大影响,因此快速且精准的肿瘤检测能力至关重要。MK-YOLOv8模型具备更快的处理速度(62帧/秒)和较高的检测精度,可部署于实时诊断工具中,帮助放射科医生和临床医生更高效地识别和分类脑肿瘤。

此外,MK-YOLOv8模型在小型肿瘤检测方面的性能提升,进一步增强了其临床应用潜力。对小型肿瘤的早期检测,有助于提升脑肿瘤患者的治疗效果和生存率。在临床场景中,精准的肿瘤检测与分类是制定合理治疗方案的关键,而该模型对不同类型肿瘤(尤其是胶质瘤)的优异检测性能,进一步证明了其临床适用性。

5.3 挑战与局限性(Challenges and limitations)

尽管研究取得了可喜的结果,但仍存在一些挑战。两种模型在背景区域误分类方面均表现出一定问题,尤其是在胶质瘤和脑膜瘤的检测中,易将背景区域误判为肿瘤。未来需进一步优化模型,以降低背景噪声干扰,提升模型区分肿瘤与非肿瘤区域的能力。具体改进方向包括:采用更先进的特征提取方法(更好地区分MRI图像中复杂的解剖结构),或在更多样化的数据集上进行训练。

数据集规模是另一项局限性。虽然FBT和Br35H数据集是模型训练与测试的宝贵资源,但它们相对较小的规模和有限的多样性,可能会影响模型在更全面、更多样化数据集上的泛化能力。扩大数据集规模(纳入更多图像、不同成像模态和各类肿瘤类型),有望提升模型的鲁棒性和临床适用性。 此外,尽管MK-YOLOv8模型的计算效率已显著提升,但其实时部署仍依赖专用硬件。未来研究可聚焦于进一步优化模型,使其适用于低资源设备(如移动设备或嵌入式系统)——这类设备在偏远地区和资源有限的医疗环境中需求日益增长。

5.4 未来研究方向(Future work)

有多个未来研究方向可进一步改进所提出的模型。首先,均衡地扩大数据集规模,纳入更广泛的MRI图像和肿瘤类型,将有助于提升模型的鲁棒性和泛化能力。其次,将该模型与计算机断层扫描(CT)、正电子发射断层扫描(PET)等多模态成像技术相结合,可实现更全面的诊断能力,从而检测和分类那些仅通过MRI扫描难以识别的肿瘤。此外,研究无监督学习技术的应用,有助于减少对大规模标注数据集的依赖——这类数据集在医学研究中往往难以获取。 最后,增强模型处理多类别分类和分割任务的能力,有望开发出更精细化的诊断工具:不仅能对肿瘤进行分类,还能精准地将肿瘤与周围组织分割开。这将提升模型在术前规划和治疗监测中的实用性,因为精准的肿瘤分割在这些场景中至关重要。

6分类模型的对比分析

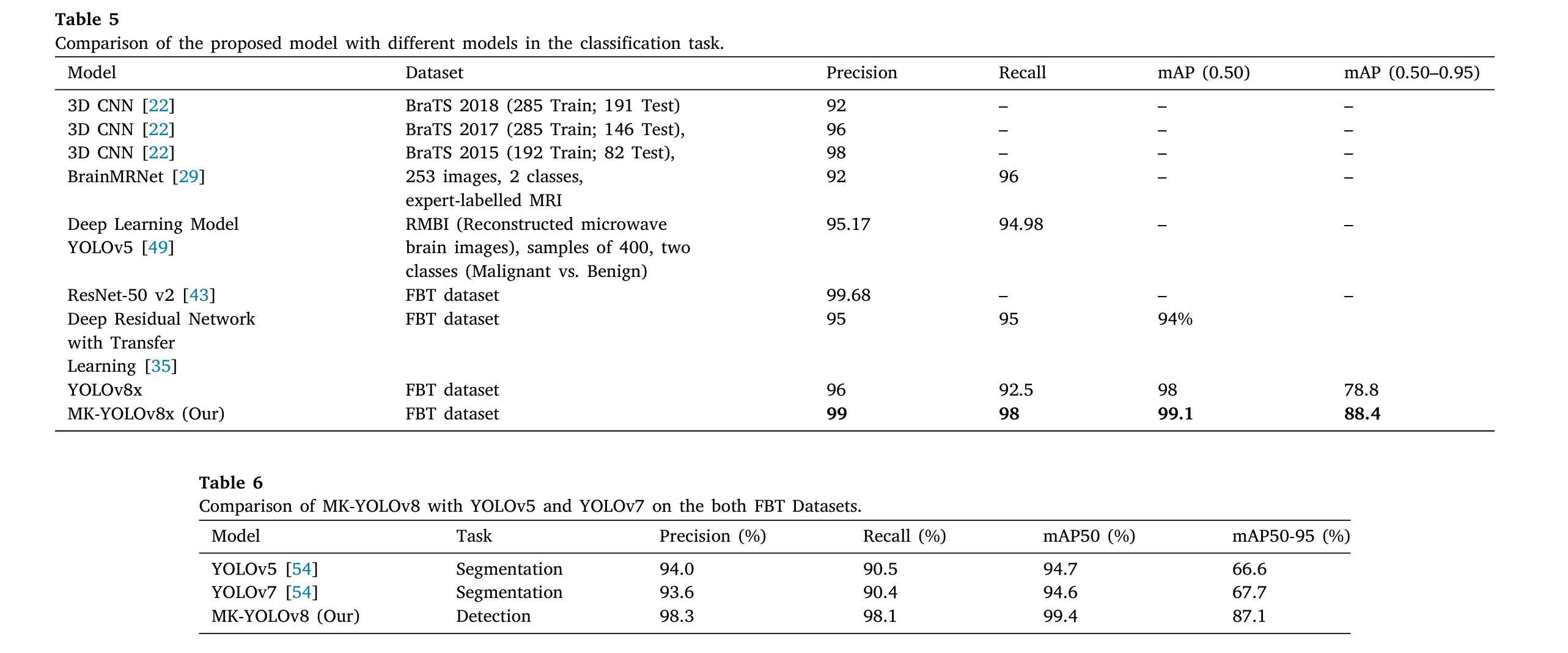

表5针对分类任务,在不同脑肿瘤数据集上对深度学习模型进行了全面比较。所评估的模型包括ResNet-50 V2[43]、深度残差网络(Deep Residual Network)[35]、3D CNN[22]、BrainMNet[29]、深度学习脑模型(Deep Learning Brain Model)、YOLOv5[49]、YOLOv8x以及MK-YOLOv8x(本文提出的模型)。其中,ResNet-50 V2模型在FBT数据集上的召回率达到99%,但其精确率和mAP指标未明确给出。同样在FBT数据集上进行测试的深度残差网络,其召回率为95%,mAP(0.50)为94%。3D CNN模型在BraTS 2015和BraTS 2017数据集上进行了测试,其召回率分别为98%和96%;其中,BraTS 2015数据集上的mAP指标未明确给出,而该模型在BraTS 2017数据集上的召回率为96%。BrainMNet模型使用的数据集包含253张经专家标注的MRI图像,分为两类,该模型的召回率为96%,精确率为92%。深度学习脑模型应用于重建的微波脑图像,其精确率为95.17%,召回率为94.98%。YOLOv5模型在包含400张脑图像(分为良性和恶性两类)的数据集上进行了评估,其召回率为92.5%、精确率为96%、mAP(0.50)为98%,mAP(0.50–0.95)为78.8%。YOLOv8x模型在FBT数据集上的精确率为96%、召回率为92.5%、mAP(0.50)为98%,mAP(0.50–0.95)为78.8%。值得注意的是,同样在FBT数据集上评估的MK-YOLOv8x(本文提出的模型)取得了最高的性能指标,其召回率为98%、精确率为99%、mAP(0.50)为99.1%,mAP(0.50–0.95)为88.4%。这些结果表明,MK-YOLOv8x(本文提出的模型)在多个评估标准下均表现出优越性能,证明其在医学影像应用中具有实现高精度、高可靠性目标检测的潜力。融合前沿方法并在多种数据集上进行测试,证明了本文提出的模型在处理具有挑战性的分类任务时的有效性和稳健性。 表6在FBT识别数据集和分割数据集上,对三个YOLO模型(YOLOv5、YOLOv7以及本文提出的模型)的性能指标进行了比较。YOLOv5[54]和YOLOv7[54]均用于执行分割任务,且表现出色;在mAP指标方面,YOLOv7的结果略优于YOLOv5。然而,本文提出的用于检测任务的模型在所有评估标准下均显著优于YOLOv5和YOLOv7。具体而言,MK-YOLOv8模型的精确率达到98.3%,mAP50达到99.4%,这表明该模型的检测能力有所提升,尤其在识别复杂肿瘤和小型肿瘤方面表现突出。这表明,对于所使用的数据集而言,MK-YOLOv8模型的检测任务比YOLOv5和YOLOv7执行的分割任务更有效。

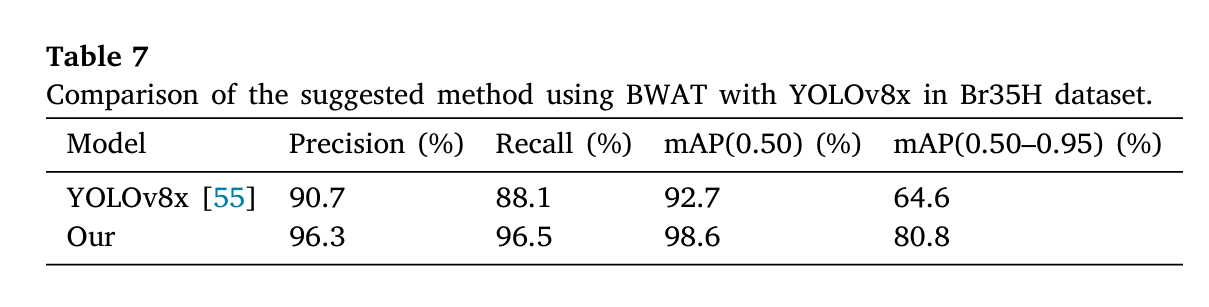

为验证MK-YOLOv8(本文提出的模型)的稳定性和泛化能力,研究人员使用Br35H数据集进一步分析了该模型的性能。表7显示,本文提出的模型在所有评估指标上均显著优于YOLOv8x模型[55]。该模型的精确率达到96.3%,召回率达到96.5%,具备出色的肿瘤准确检测和识别能力。此外,与YOLOv8x模型(mAP(0.50)为92.7%,mAP(0.50–0.95)为64.6%)相比,本文提出的模型在这两项指标上分别大幅提升至98.6%和80.8%。这些结果表明,所提模型不仅在FBT数据集上表现优异,而且在应用于Br35H等不同数据集时,也展现出更强的泛化能力。

7. 消融实验(Ablation Study)

为验证本文提出的MK-YOLOv8模型的稳定性与泛化能力,研究人员利用Br35H数据集进一步分析了该模型的性能。表7显示,本文提出的模型在所有评估指标上均显著优于YOLOv8x模型[55]。该模型的精确率达96.3%、召回率达96.5%,具备出色的肿瘤准确检测与识别能力。此外,相较于YOLOv8x模型(mAP(0.50)为92.7%、mAP(0.50–0.95)为64.6%),本文提出的模型在这两项指标上分别大幅提升至98.6%和80.8%。这些结果表明,所提模型不仅在FBT数据集上表现优异,在应用于Br35H等不同数据集时,也展现出更强的泛化能力。

如图14所示,研究人员通过评估多个关键指标,分析了YOLOv8x与MK-YOLOv8x模型之间的结构与计算差异。首先,MK-YOLOv8x拥有更深的网络结构,其层数达802层,远多于YOLOv8x的365层;在参数数量上,YOLOv8x使用6820万个参数,而MK-YOLOv8x在训练过程中仅使用1260万个参数(仅为YOLOv8参数数量的18.5%),呈现出更高效的参数分布。在训练阶段的内存需求方面,YOLOv8x需要2.581亿个梯度,远多于MK-YOLOv8x的1660万个,因此MK-YOLOv8x的内存需求更低(梯度对模型训练至关重要)。最后,作为衡量计算效率的指标,每秒十亿次浮点运算(GFLOPS)结果显示,MK-YOLOv8x的计算效率更高:其仅需96.9 GFLOPS,仅为YOLOv8x(258.1 GFLOPS)的37.5%。综合上述全面对比及前一部分的实验结果可知,尽管MK-YOLOv8x(本文提出的模型)的网络结构更复杂,但它消耗的资源更少、性能更优,因此在实际应用中更具实用性。

8. 结论(Conclusion)

本研究针对脑肿瘤的检测与分类任务,研究了基于YOLO的机器学习模型,重点关注垂体瘤、胶质瘤和脑膜瘤三类肿瘤。实验结果表明,YOLOv8架构及本文提出的MK-YOLOv8模型在这三类肿瘤的定位与检测中均表现出优异的精度。值得注意的是,MK-YOLOv8在检测更小肿瘤区域时性能更优,尤其在检测胶质瘤和垂体瘤方面表现突出——这两类肿瘤因形态复杂,通常更难被检测。与基准模型YOLOv8相比,MK-YOLOv8在召回率和mAP分数上有显著提升,且在所有肿瘤类型上的精确率始终超过99%。 通过采用最佳权重自适应技术(Best Weight Adaptation Technique, BWAT),模型的稳健性进一步提升,尤其是在检测率通常较低的胶质瘤检测任务中。在脑膜瘤、胶质瘤和垂体瘤三类肿瘤的检测中,模型的召回率均稳定在0.95以上,这表明该模型在不同大小和形态的肿瘤上均具有良好的泛化能力。此外,本研究成功将FTP数据集转换为YOLO格式,并将肿瘤掩码与MRI图像对齐,确保了与基于YOLO的模型的兼容性。这种数据格式转换不仅实现了高效的模型训练,还提升了模型在脑肿瘤定位任务中的性能。 这些结果凸显了MK-YOLOv8模型的潜力:相较于传统模型,它能以更高的精度和效率改进自动化脑肿瘤诊断。本研究还证实了基于YOLO的模型在临床应用中的可扩展性和实时处理能力,为医学图像分析的未来发展与进步,以及将轻量级、高精度模型集成到医疗系统中提供了宝贵见解。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)